- | Number of timeseries (frequency<=1HZ) |

+ Number of timeseries (frequency<=1HZ) |

Memory |

Number of nodes |

diff --git a/src/zh/UserGuide/Master/Table/API/Programming-JDBC.md b/src/zh/UserGuide/Master/Table/API/Programming-JDBC.md

new file mode 100644

index 000000000..c5b57096e

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/API/Programming-JDBC.md

@@ -0,0 +1,191 @@

+

+

+# JDBC接口

+

+## 1 功能介绍

+

+IoTDB JDBC接口提供了一种标准的方式来与IoTDB数据库进行交互,允许用户通过Java程序执行SQL语句来管理数据库和时间序列数据。它支持数据库的连接、创建、查询、更新和删除操作,以及时间序列数据的批量插入和查询。

+

+**注意**: 目前的JDBC实现仅是为与第三方工具连接使用的。使用JDBC(执行插入语句时)无法提供高性能写入。

+

+对于Java应用,我们推荐使用Java 原生接口。

+

+## 2 使用方式

+

+**环境要求:**

+

+- JDK >= 1.8

+- Maven >= 3.6

+

+**在maven中添加依赖:**

+

+```XML

+

+

+ com.timecho.iotdb

+ iotdb-jdbc

+ 2.0.1.1

+

+

+```

+

+## 3 读写操作

+

+### 3.1 功能说明

+

+- **写操作**:通过execute方法执行插入、创建数据库、创建时间序列等操作。

+- **读操作**:通过executeQuery方法执行查询操作,并使用ResultSet对象获取查询结果。

+

+### 3.2 **方法列表**

+

+| **方法名** | **描述** | **参数** | **返回值** |

+| ------------------------------------------------------------ | ---------------------------------- | ---------------------------------------------------------- | ----------------------------------- |

+| Class.forName(String driver) | 加载JDBC驱动类 | driver: JDBC驱动类的名称 | Class: 加载的类对象 |

+| DriverManager.getConnection(String url, String username, String password) | 建立数据库连接 | url: 数据库的URLusername: 数据库用户名password: 数据库密码 | Connection: 数据库连接对象 |

+| Connection.createStatement() | 创建Statement对象,用于执行SQL语句 | 无 | Statement: SQL语句执行对象 |

+| Statement.execute(String sql) | 执行SQL语句,对于非查询语句 | sql: 要执行的SQL语句 | boolean: 指示是否返回ResultSet对象 |

+| Statement.executeQuery(String sql) | 执行查询SQL语句并返回结果集 | sql: 要执行的查询SQL语句 | ResultSet: 查询结果集 |

+| ResultSet.getMetaData() | 获取结果集的元数据 | 无 | ResultSetMetaData: 结果集元数据对象 |

+| ResultSet.next() | 移动到结果集的下一行 | 无 | boolean: 是否成功移动到下一行 |

+| ResultSet.getString(int columnIndex) | 获取指定列的字符串值 | columnIndex: 列索引(从1开始) | String: 列的字符串值 |

+

+## 4 示例代码

+

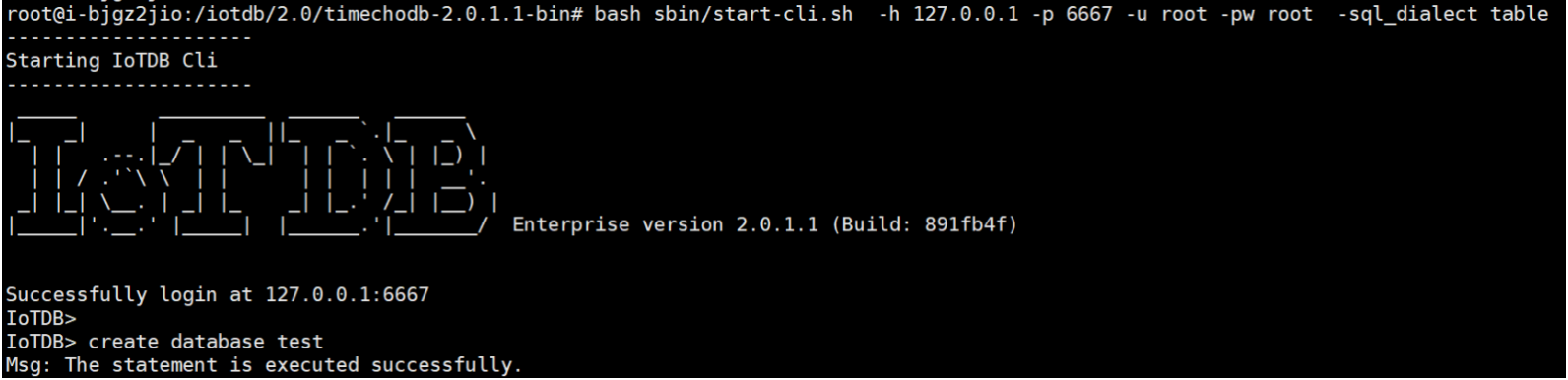

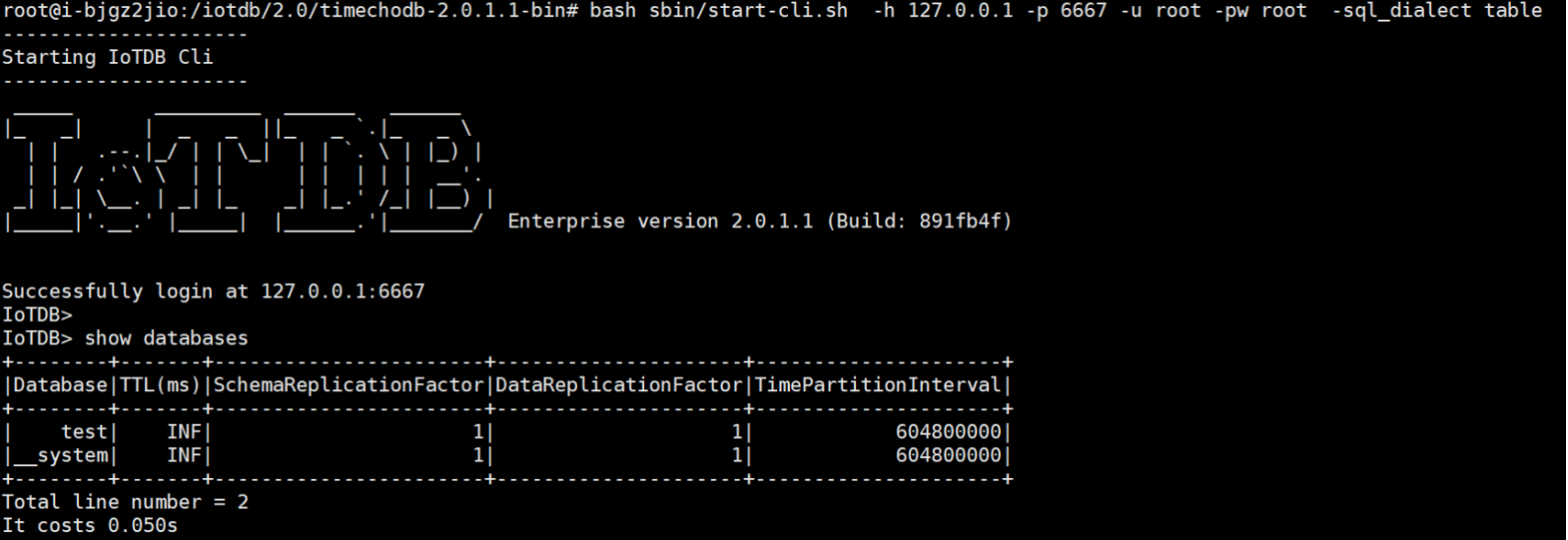

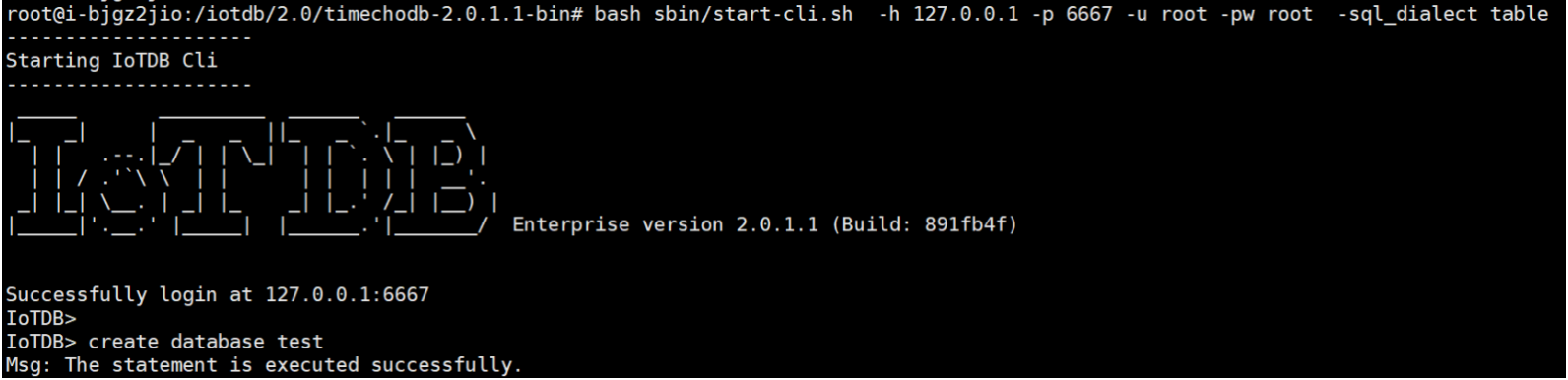

+**注意:使用表模型,必须在 url 中指定 sql_dialect 参数为 table。**

+

+```Java

+String url = "jdbc:iotdb://127.0.0.1:6667?sql_dialect=table";

+```

+

+JDBC接口示例代码:[src/main/java/org/apache/iotdb/TableModelJDBCExample.java](https://github.com/apache/iotdb/blob/master/example/jdbc/src/main/java/org/apache/iotdb/TableModelJDBCExample.java)

+

+

+```Java

+/*

+ * Licensed to the Apache Software Foundation (ASF) under one

+ * or more contributor license agreements. See the NOTICE file

+ * distributed with this work for additional information

+ * regarding copyright ownership. The ASF licenses this file

+ * to you under the Apache License, Version 2.0 (the

+ * "License"); you may not use this file except in compliance

+ * with the License. You may obtain a copy of the License at

+ *

+ * http://www.apache.org/licenses/LICENSE-2.0

+ *

+ * Unless required by applicable law or agreed to in writing,

+ * software distributed under the License is distributed on an

+ * "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

+ * KIND, either express or implied. See the License for the

+ * specific language governing permissions and limitations

+ * under the License.

+ */

+

+package org.apache.iotdb;

+

+import org.apache.iotdb.jdbc.IoTDBSQLException;

+

+import org.slf4j.Logger;

+import org.slf4j.LoggerFactory;

+

+import java.sql.Connection;

+import java.sql.DriverManager;

+import java.sql.ResultSet;

+import java.sql.ResultSetMetaData;

+import java.sql.SQLException;

+import java.sql.Statement;

+

+public class TableModelJDBCExample {

+

+ private static final Logger LOGGER = LoggerFactory.getLogger(TableModelJDBCExample.class);

+

+ public static void main(String[] args) throws ClassNotFoundException, SQLException {

+ Class.forName("org.apache.iotdb.jdbc.IoTDBDriver");

+

+ // don't specify database in url

+ try (Connection connection =

+ DriverManager.getConnection(

+ "jdbc:iotdb://127.0.0.1:6667?sql_dialect=table", "root", "root");

+ Statement statement = connection.createStatement()) {

+

+ statement.execute("CREATE DATABASE test1");

+ statement.execute("CREATE DATABASE test2");

+

+ statement.execute("use test2");

+

+ // or use full qualified table name

+ statement.execute(

+ "create table test1.table1(region_id STRING ID, plant_id STRING ID, device_id STRING ID, model STRING ATTRIBUTE, temperature FLOAT MEASUREMENT, humidity DOUBLE MEASUREMENT) with (TTL=3600000)");

+

+ statement.execute(

+ "create table table2(region_id STRING ID, plant_id STRING ID, color STRING ATTRIBUTE, temperature FLOAT MEASUREMENT, speed DOUBLE MEASUREMENT) with (TTL=6600000)");

+

+ // show tables from current database

+ try (ResultSet resultSet = statement.executeQuery("SHOW TABLES")) {

+ ResultSetMetaData metaData = resultSet.getMetaData();

+ System.out.println(metaData.getColumnCount());

+ while (resultSet.next()) {

+ System.out.println(resultSet.getString(1) + ", " + resultSet.getInt(2));

+ }

+ }

+

+ // show tables by specifying another database

+ // using SHOW tables FROM

+ try (ResultSet resultSet = statement.executeQuery("SHOW TABLES FROM test1")) {

+ ResultSetMetaData metaData = resultSet.getMetaData();

+ System.out.println(metaData.getColumnCount());

+ while (resultSet.next()) {

+ System.out.println(resultSet.getString(1) + ", " + resultSet.getInt(2));

+ }

+ }

+

+ } catch (IoTDBSQLException e) {

+ LOGGER.error("IoTDB Jdbc example error", e);

+ }

+

+ // specify database in url

+ try (Connection connection =

+ DriverManager.getConnection(

+ "jdbc:iotdb://127.0.0.1:6667/test1?sql_dialect=table", "root", "root");

+ Statement statement = connection.createStatement()) {

+ // show tables from current database test1

+ try (ResultSet resultSet = statement.executeQuery("SHOW TABLES")) {

+ ResultSetMetaData metaData = resultSet.getMetaData();

+ System.out.println(metaData.getColumnCount());

+ while (resultSet.next()) {

+ System.out.println(resultSet.getString(1) + ", " + resultSet.getInt(2));

+ }

+ }

+

+ // change database to test2

+ statement.execute("use test2");

+

+ try (ResultSet resultSet = statement.executeQuery("SHOW TABLES")) {

+ ResultSetMetaData metaData = resultSet.getMetaData();

+ System.out.println(metaData.getColumnCount());

+ while (resultSet.next()) {

+ System.out.println(resultSet.getString(1) + ", " + resultSet.getInt(2));

+ }

+ }

+ }

+ }

+}

+```

\ No newline at end of file

diff --git a/src/zh/UserGuide/Master/Table/API/Programming-Java-Native-API.md b/src/zh/UserGuide/Master/Table/API/Programming-Java-Native-API.md

new file mode 100644

index 000000000..e97273103

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/API/Programming-Java-Native-API.md

@@ -0,0 +1,860 @@

+

+

+# Java Session原生接口

+

+## 1 功能介绍

+

+IoTDB具备Java原生客户端驱动和对应的连接池,提供对象化接口,可以直接组装时序对象进行写入,无需拼装 SQL。推荐使用连接池,多线程并行操作数据库。

+

+## 2 使用方式

+

+**环境要求:**

+

+- JDK >= 1.8

+- Maven >= 3.6

+

+**在maven中添加依赖:**

+

+```XML

+

+

+ com.timecho.iotdb

+ iotdb-session

+ 2.0.1.1

+

+

+```

+

+## 3 读写操作

+

+### 3.1 ITableSession接口

+

+#### 3.1.1 功能描述

+

+ITableSession接口定义了与IoTDB交互的基本操作,可以执行数据插入、查询操作以及关闭会话等,非线程安全。

+

+#### 3.1.2 方法列表

+

+以下是ITableSession接口中定义的方法及其详细说明:

+

+| **方法名** | **描述** | **参数** | **返回值** | **返回异常** |

+| --------------------------------------------------- | ------------------------------------------------------------ | ----------------------------------------------------------- | -------------- | --------------------------------------------------- |

+| insert(Tablet tablet) | 将一个包含时间序列数据的Tablet 对象插入到数据库中 | tablet: 要插入的Tablet对象 | 无 | StatementExecutionExceptionIoTDBConnectionException |

+| executeNonQueryStatement(String sql) | 执行非查询SQL语句,如DDL(数据定义语言)或DML(数据操作语言)命令 | sql: 要执行的SQL语句。 | 无 | StatementExecutionExceptionIoTDBConnectionException |

+| executeQueryStatement(String sql) | 执行查询SQL语句,并返回包含查询结果的SessionDataSet对象 | sql: 要执行的查询SQL语句。 | SessionDataSet | StatementExecutionExceptionIoTDBConnectionException |

+| executeQueryStatement(String sql, long timeoutInMs) | 执行查询SQL语句,并设置查询超时时间(以毫秒为单位) | sql: 要执行的查询SQL语句。timeoutInMs: 查询超时时间(毫秒) | SessionDataSet | StatementExecutionException |

+| close() | 关闭会话,释放所持有的资源 | 无 | 无 | IoTDBConnectionException |

+

+#### 3.1.2 接口展示

+

+``` java

+/**

+ * This interface defines a session for interacting with IoTDB tables.

+ * It supports operations such as data insertion, executing queries, and closing the session.

+ * Implementations of this interface are expected to manage connections and ensure

+ * proper resource cleanup.

+ *

+ * Each method may throw exceptions to indicate issues such as connection errors or

+ * execution failures.

+ *

+ *

Since this interface extends {@link AutoCloseable}, it is recommended to use

+ * try-with-resources to ensure the session is properly closed.

+ */

+public interface ITableSession extends AutoCloseable {

+

+ /**

+ * Inserts a {@link Tablet} into the database.

+ *

+ * @param tablet the tablet containing time-series data to be inserted.

+ * @throws StatementExecutionException if an error occurs while executing the statement.

+ * @throws IoTDBConnectionException if there is an issue with the IoTDB connection.

+ */

+ void insert(Tablet tablet) throws StatementExecutionException, IoTDBConnectionException;

+

+ /**

+ * Executes a non-query SQL statement, such as a DDL or DML command.

+ *

+ * @param sql the SQL statement to execute.

+ * @throws IoTDBConnectionException if there is an issue with the IoTDB connection.

+ * @throws StatementExecutionException if an error occurs while executing the statement.

+ */

+ void executeNonQueryStatement(String sql) throws IoTDBConnectionException, StatementExecutionException;

+

+ /**

+ * Executes a query SQL statement and returns the result set.

+ *

+ * @param sql the SQL query statement to execute.

+ * @return a {@link SessionDataSet} containing the query results.

+ * @throws StatementExecutionException if an error occurs while executing the statement.

+ * @throws IoTDBConnectionException if there is an issue with the IoTDB connection.

+ */

+ SessionDataSet executeQueryStatement(String sql)

+ throws StatementExecutionException, IoTDBConnectionException;

+

+ /**

+ * Executes a query SQL statement with a specified timeout and returns the result set.

+ *

+ * @param sql the SQL query statement to execute.

+ * @param timeoutInMs the timeout duration in milliseconds for the query execution.

+ * @return a {@link SessionDataSet} containing the query results.

+ * @throws StatementExecutionException if an error occurs while executing the statement.

+ * @throws IoTDBConnectionException if there is an issue with the IoTDB connection.

+ */

+ SessionDataSet executeQueryStatement(String sql, long timeoutInMs)

+ throws StatementExecutionException, IoTDBConnectionException;

+

+ /**

+ * Closes the session, releasing any held resources.

+ *

+ * @throws IoTDBConnectionException if there is an issue with closing the IoTDB connection.

+ */

+ @Override

+ void close() throws IoTDBConnectionException;

+}

+```

+

+### 3.2 TableSessionBuilder类

+

+#### 3.2.1 功能描述

+

+TableSessionBuilder类是一个构建器,用于配置和创建ITableSession接口的实例。它允许开发者设置连接参数、查询参数和安全特性等。

+

+#### 3.2.2 配置选项

+

+以下是TableSessionBuilder类中可用的配置选项及其默认值:

+

+| **配置项** | **描述** | **默认值** |

+| ---------------------------------------------------- | ---------------------------------------- | ------------------------------------------- |

+| nodeUrls(List`` nodeUrls) | 设置IoTDB集群的节点URL列表 | Collections.singletonList("localhost:6667") |

+| username(String username) | 设置连接的用户名 | "root" |

+| password(String password) | 设置连接的密码 | "root" |

+| database(String database) | 设置目标数据库名称 | null |

+| queryTimeoutInMs(long queryTimeoutInMs) | 设置查询超时时间(毫秒) | 60000(1分钟) |

+| fetchSize(int fetchSize) | 设置查询结果的获取大小 | 5000 |

+| zoneId(ZoneId zoneId) | 设置时区相关的ZoneId | ZoneId.systemDefault() |

+| thriftDefaultBufferSize(int thriftDefaultBufferSize) | 设置Thrift客户端的默认缓冲区大小(字节) | 1024(1KB) |

+| thriftMaxFrameSize(int thriftMaxFrameSize) | 设置Thrift客户端的最大帧大小(字节) | 64 * 1024 * 1024(64MB) |

+| enableRedirection(boolean enableRedirection) | 是否启用集群节点的重定向 | true |

+| enableAutoFetch(boolean enableAutoFetch) | 是否启用自动获取可用DataNodes | true |

+| maxRetryCount(int maxRetryCount) | 设置连接尝试的最大重试次数 | 60 |

+| retryIntervalInMs(long retryIntervalInMs) | 设置重试间隔时间(毫秒) | 500 |

+| useSSL(boolean useSSL) | 是否启用SSL安全连接 | false |

+| trustStore(String keyStore) | 设置SSL连接的信任库路径 | null |

+| trustStorePwd(String keyStorePwd) | 设置SSL连接的信任库密码 | null |

+| enableCompression(boolean enableCompression) | 是否启用RPC压缩 | false |

+| connectionTimeoutInMs(int connectionTimeoutInMs) | 设置连接超时时间(毫秒) | 0(无超时) |

+

+#### 3.2.3 接口展示

+

+``` java

+/**

+ * A builder class for constructing instances of {@link ITableSession}.

+ *

+ * This builder provides a fluent API for configuring various options such as connection

+ * settings, query parameters, and security features.

+ *

+ *

All configurations have reasonable default values, which can be overridden as needed.

+ */

+public class TableSessionBuilder {

+

+ /**

+ * Builds and returns a configured {@link ITableSession} instance.

+ *

+ * @return a fully configured {@link ITableSession}.

+ * @throws IoTDBConnectionException if an error occurs while establishing the connection.

+ */

+ public ITableSession build() throws IoTDBConnectionException;

+

+ /**

+ * Sets the list of node URLs for the IoTDB cluster.

+ *

+ * @param nodeUrls a list of node URLs.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue Collection.singletonList("localhost:6667")

+ */

+ public TableSessionBuilder nodeUrls(List nodeUrls);

+

+ /**

+ * Sets the username for the connection.

+ *

+ * @param username the username.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue "root"

+ */

+ public TableSessionBuilder username(String username);

+

+ /**

+ * Sets the password for the connection.

+ *

+ * @param password the password.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue "root"

+ */

+ public TableSessionBuilder password(String password);

+

+ /**

+ * Sets the target database name.

+ *

+ * @param database the database name.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue null

+ */

+ public TableSessionBuilder database(String database);

+

+ /**

+ * Sets the query timeout in milliseconds.

+ *

+ * @param queryTimeoutInMs the query timeout in milliseconds.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 60000 (1 minute)

+ */

+ public TableSessionBuilder queryTimeoutInMs(long queryTimeoutInMs);

+

+ /**

+ * Sets the fetch size for query results.

+ *

+ * @param fetchSize the fetch size.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 5000

+ */

+ public TableSessionBuilder fetchSize(int fetchSize);

+

+ /**

+ * Sets the {@link ZoneId} for timezone-related operations.

+ *

+ * @param zoneId the {@link ZoneId}.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue ZoneId.systemDefault()

+ */

+ public TableSessionBuilder zoneId(ZoneId zoneId);

+

+ /**

+ * Sets the default init buffer size for the Thrift client.

+ *

+ * @param thriftDefaultBufferSize the buffer size in bytes.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 1024 (1 KB)

+ */

+ public TableSessionBuilder thriftDefaultBufferSize(int thriftDefaultBufferSize);

+

+ /**

+ * Sets the maximum frame size for the Thrift client.

+ *

+ * @param thriftMaxFrameSize the maximum frame size in bytes.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 64 * 1024 * 1024 (64 MB)

+ */

+ public TableSessionBuilder thriftMaxFrameSize(int thriftMaxFrameSize);

+

+ /**

+ * Enables or disables redirection for cluster nodes.

+ *

+ * @param enableRedirection whether to enable redirection.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue true

+ */

+ public TableSessionBuilder enableRedirection(boolean enableRedirection);

+

+ /**

+ * Enables or disables automatic fetching of available DataNodes.

+ *

+ * @param enableAutoFetch whether to enable automatic fetching.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue true

+ */

+ public TableSessionBuilder enableAutoFetch(boolean enableAutoFetch);

+

+ /**

+ * Sets the maximum number of retries for connection attempts.

+ *

+ * @param maxRetryCount the maximum retry count.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 60

+ */

+ public TableSessionBuilder maxRetryCount(int maxRetryCount);

+

+ /**

+ * Sets the interval between retries in milliseconds.

+ *

+ * @param retryIntervalInMs the interval in milliseconds.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 500 milliseconds

+ */

+ public TableSessionBuilder retryIntervalInMs(long retryIntervalInMs);

+

+ /**

+ * Enables or disables SSL for secure connections.

+ *

+ * @param useSSL whether to enable SSL.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue false

+ */

+ public TableSessionBuilder useSSL(boolean useSSL);

+

+ /**

+ * Sets the trust store path for SSL connections.

+ *

+ * @param keyStore the trust store path.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue null

+ */

+ public TableSessionBuilder trustStore(String keyStore);

+

+ /**

+ * Sets the trust store password for SSL connections.

+ *

+ * @param keyStorePwd the trust store password.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue null

+ */

+ public TableSessionBuilder trustStorePwd(String keyStorePwd);

+

+ /**

+ * Enables or disables rpc compression for the connection.

+ *

+ * @param enableCompression whether to enable compression.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue false

+ */

+ public TableSessionBuilder enableCompression(boolean enableCompression);

+

+ /**

+ * Sets the connection timeout in milliseconds.

+ *

+ * @param connectionTimeoutInMs the connection timeout in milliseconds.

+ * @return the current {@link TableSessionBuilder} instance.

+ * @defaultValue 0 (no timeout)

+ */

+ public TableSessionBuilder connectionTimeoutInMs(int connectionTimeoutInMs);

+}

+```

+

+## 4 客户端连接池

+

+### 4.1 ITableSessionPool 接口

+

+#### 4.1.1 功能描述

+

+ITableSessionPool 是一个用于管理 ITableSession实例的池。这个池可以帮助我们高效地重用连接,并且在不需要时正确地清理资源, 该接口定义了如何从池中获取会话以及如何关闭池的基本操作。

+

+#### 4.1.2 方法列表

+

+| **方法名** | **描述** | **返回值** | **返回异常** |

+| ------------ | ------------------------------------------------------------ | ------------------ | ------------------------ |

+| getSession() | 从池中获取一个 ITableSession 实例,用于与 IoTDB 交互。 | ITableSession 实例 | IoTDBConnectionException |

+| close() | 关闭会话池,释放任何持有的资源。关闭后,不能再从池中获取新的会话。 | 无 | 无 |

+

+#### 4.1.3 接口展示

+

+```Java

+/**

+ * This interface defines a pool for managing {@link ITableSession} instances.

+ * It provides methods to acquire a session from the pool and to close the pool.

+ *

+ * The implementation should handle the lifecycle of sessions, ensuring efficient

+ * reuse and proper cleanup of resources.

+ */

+public interface ITableSessionPool {

+

+ /**

+ * Acquires an {@link ITableSession} instance from the pool.

+ *

+ * @return an {@link ITableSession} instance for interacting with the IoTDB.

+ * @throws IoTDBConnectionException if there is an issue obtaining a session from the pool.

+ */

+ ITableSession getSession() throws IoTDBConnectionException;

+

+ /**

+ * Closes the session pool, releasing any held resources.

+ *

+ *

Once the pool is closed, no further sessions can be acquired.

+ */

+ void close();

+}

+```

+

+### 4.2 TableSessionPoolBuilder 类

+

+#### 4.2.1 功能描述

+

+TableSessionPool 的构造器,用于配置和创建 ITableSessionPool 的实例。允许开发者配置连接参数、会话参数和池化行为等。

+

+#### 4.2.2 配置选项

+

+以下是 TableSessionPoolBuilder 类的可用配置选项及其默认值:

+

+| **配置项** | **描述** | **默认值** |

+| ------------------------------------------------------------ | -------------------------------------------- | ------------------------------------------- |

+| nodeUrls(List`` nodeUrls) | 设置IoTDB集群的节点URL列表 | Collections.singletonList("localhost:6667") |

+| maxSize(int maxSize) | 设置会话池的最大大小,即池中允许的最大会话数 | 5 |

+| user(String user) | 设置连接的用户名 | "root" |

+| password(String password) | 设置连接的密码 | "root" |

+| database(String database) | 设置目标数据库名称 | "root" |

+| queryTimeoutInMs(long queryTimeoutInMs) | 设置查询超时时间(毫秒) | 60000(1分钟) |

+| fetchSize(int fetchSize) | 设置查询结果的获取大小 | 5000 |

+| zoneId(ZoneId zoneId) | 设置时区相关的 ZoneId | ZoneId.systemDefault() |

+| waitToGetSessionTimeoutInMs(long waitToGetSessionTimeoutInMs) | 设置从池中获取会话的超时时间(毫秒) | 30000(30秒) |

+| thriftDefaultBufferSize(int thriftDefaultBufferSize) | 设置Thrift客户端的默认缓冲区大小(字节) | 1024(1KB) |

+| thriftMaxFrameSize(int thriftMaxFrameSize) | 设置Thrift客户端的最大帧大小(字节) | 64 * 1024 * 1024(64MB) |

+| enableCompression(boolean enableCompression) | 是否启用连接的压缩 | false |

+| enableRedirection(boolean enableRedirection) | 是否启用集群节点的重定向 | true |

+| connectionTimeoutInMs(int connectionTimeoutInMs) | 设置连接超时时间(毫秒) | 10000(10秒) |

+| enableAutoFetch(boolean enableAutoFetch) | 是否启用自动获取可用DataNodes | true |

+| maxRetryCount(int maxRetryCount) | 设置连接尝试的最大重试次数 | 60 |

+| retryIntervalInMs(long retryIntervalInMs) | 设置重试间隔时间(毫秒) | 500 |

+| useSSL(boolean useSSL) | 是否启用SSL安全连接 | false |

+| trustStore(String keyStore) | 设置SSL连接的信任库路径 | null |

+| trustStorePwd(String keyStorePwd) | 设置SSL连接的信任库密码 | null |

+

+#### 4.1.3 接口展示

+

+```Java

+/**

+ * A builder class for constructing instances of {@link ITableSessionPool}.

+ *

+ * This builder provides a fluent API for configuring a session pool, including

+ * connection settings, session parameters, and pool behavior.

+ *

+ *

All configurations have reasonable default values, which can be overridden as needed.

+ */

+public class TableSessionPoolBuilder {

+

+ /**

+ * Builds and returns a configured {@link ITableSessionPool} instance.

+ *

+ * @return a fully configured {@link ITableSessionPool}.

+ */

+ public ITableSessionPool build();

+

+ /**

+ * Sets the list of node URLs for the IoTDB cluster.

+ *

+ * @param nodeUrls a list of node URLs.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue Collection.singletonList("localhost:6667")

+ */

+ public TableSessionPoolBuilder nodeUrls(List nodeUrls);

+

+ /**

+ * Sets the maximum size of the session pool.

+ *

+ * @param maxSize the maximum number of sessions allowed in the pool.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 5

+ */

+ public TableSessionPoolBuilder maxSize(int maxSize);

+

+ /**

+ * Sets the username for the connection.

+ *

+ * @param user the username.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue "root"

+ */

+ public TableSessionPoolBuilder user(String user);

+

+ /**

+ * Sets the password for the connection.

+ *

+ * @param password the password.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue "root"

+ */

+ public TableSessionPoolBuilder password(String password);

+

+ /**

+ * Sets the target database name.

+ *

+ * @param database the database name.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue "root"

+ */

+ public TableSessionPoolBuilder database(String database);

+

+ /**

+ * Sets the query timeout in milliseconds.

+ *

+ * @param queryTimeoutInMs the query timeout in milliseconds.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 60000 (1 minute)

+ */

+ public TableSessionPoolBuilder queryTimeoutInMs(long queryTimeoutInMs);

+

+ /**

+ * Sets the fetch size for query results.

+ *

+ * @param fetchSize the fetch size.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 5000

+ */

+ public TableSessionPoolBuilder fetchSize(int fetchSize);

+

+ /**

+ * Sets the {@link ZoneId} for timezone-related operations.

+ *

+ * @param zoneId the {@link ZoneId}.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue ZoneId.systemDefault()

+ */

+ public TableSessionPoolBuilder zoneId(ZoneId zoneId);

+

+ /**

+ * Sets the timeout for waiting to acquire a session from the pool.

+ *

+ * @param waitToGetSessionTimeoutInMs the timeout duration in milliseconds.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 30000 (30 seconds)

+ */

+ public TableSessionPoolBuilder waitToGetSessionTimeoutInMs(long waitToGetSessionTimeoutInMs);

+

+ /**

+ * Sets the default buffer size for the Thrift client.

+ *

+ * @param thriftDefaultBufferSize the buffer size in bytes.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 1024 (1 KB)

+ */

+ public TableSessionPoolBuilder thriftDefaultBufferSize(int thriftDefaultBufferSize);

+

+ /**

+ * Sets the maximum frame size for the Thrift client.

+ *

+ * @param thriftMaxFrameSize the maximum frame size in bytes.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 64 * 1024 * 1024 (64 MB)

+ */

+ public TableSessionPoolBuilder thriftMaxFrameSize(int thriftMaxFrameSize);

+

+ /**

+ * Enables or disables compression for the connection.

+ *

+ * @param enableCompression whether to enable compression.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue false

+ */

+ public TableSessionPoolBuilder enableCompression(boolean enableCompression);

+

+ /**

+ * Enables or disables redirection for cluster nodes.

+ *

+ * @param enableRedirection whether to enable redirection.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue true

+ */

+ public TableSessionPoolBuilder enableRedirection(boolean enableRedirection);

+

+ /**

+ * Sets the connection timeout in milliseconds.

+ *

+ * @param connectionTimeoutInMs the connection timeout in milliseconds.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 10000 (10 seconds)

+ */

+ public TableSessionPoolBuilder connectionTimeoutInMs(int connectionTimeoutInMs);

+

+ /**

+ * Enables or disables automatic fetching of available DataNodes.

+ *

+ * @param enableAutoFetch whether to enable automatic fetching.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue true

+ */

+ public TableSessionPoolBuilder enableAutoFetch(boolean enableAutoFetch);

+

+ /**

+ * Sets the maximum number of retries for connection attempts.

+ *

+ * @param maxRetryCount the maximum retry count.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 60

+ */

+ public TableSessionPoolBuilder maxRetryCount(int maxRetryCount);

+

+ /**

+ * Sets the interval between retries in milliseconds.

+ *

+ * @param retryIntervalInMs the interval in milliseconds.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue 500 milliseconds

+ */

+ public TableSessionPoolBuilder retryIntervalInMs(long retryIntervalInMs);

+

+ /**

+ * Enables or disables SSL for secure connections.

+ *

+ * @param useSSL whether to enable SSL.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue false

+ */

+ public TableSessionPoolBuilder useSSL(boolean useSSL);

+

+ /**

+ * Sets the trust store path for SSL connections.

+ *

+ * @param keyStore the trust store path.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue null

+ */

+ public TableSessionPoolBuilder trustStore(String keyStore);

+

+ /**

+ * Sets the trust store password for SSL connections.

+ *

+ * @param keyStorePwd the trust store password.

+ * @return the current {@link TableSessionPoolBuilder} instance.

+ * @defaultValue null

+ */

+ public TableSessionPoolBuilder trustStorePwd(String keyStorePwd);

+}

+```

+

+## 5 示例代码

+

+Session 示例代码:[src/main/java/org/apache/iotdb/TableModelSessionExample.java](https://github.com/apache/iotdb/blob/master/example/session/src/main/java/org/apache/iotdb/TableModelSessionExample.java)

+

+SessionPool 示例代码:[src/main/java/org/apache/iotdb/TableModelSessionPoolExample.java](https://github.com/apache/iotdb/blob/master/example/session/src/main/java/org/apache/iotdb/TableModelSessionPoolExample.java)

+

+```Java

+/*

+ * Licensed to the Apache Software Foundation (ASF) under one

+ * or more contributor license agreements. See the NOTICE file

+ * distributed with this work for additional information

+ * regarding copyright ownership. The ASF licenses this file

+ * to you under the Apache License, Version 2.0 (the

+ * "License"); you may not use this file except in compliance

+ * with the License. You may obtain a copy of the License at

+ *

+ * http://www.apache.org/licenses/LICENSE-2.0

+ *

+ * Unless required by applicable law or agreed to in writing,

+ * software distributed under the License is distributed on an

+ * "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

+ * KIND, either express or implied. See the License for the

+ * specific language governing permissions and limitations

+ * under the License.

+ */

+

+package org.apache.iotdb;

+

+import org.apache.iotdb.isession.ITableSession;

+import org.apache.iotdb.isession.SessionDataSet;

+import org.apache.iotdb.isession.pool.ITableSessionPool;

+import org.apache.iotdb.rpc.IoTDBConnectionException;

+import org.apache.iotdb.rpc.StatementExecutionException;

+import org.apache.iotdb.session.pool.TableSessionPoolBuilder;

+

+import org.apache.tsfile.enums.TSDataType;

+import org.apache.tsfile.write.record.Tablet;

+import org.apache.tsfile.write.record.Tablet.ColumnCategory;

+import org.apache.tsfile.write.schema.IMeasurementSchema;

+import org.apache.tsfile.write.schema.MeasurementSchema;

+

+import java.util.ArrayList;

+import java.util.Arrays;

+import java.util.Collections;

+import java.util.List;

+

+public class TableModelSessionPoolExample {

+

+ private static final String LOCAL_URL = "127.0.0.1:6667";

+

+ public static void main(String[] args) {

+

+ // don't specify database in constructor

+ ITableSessionPool tableSessionPool =

+ new TableSessionPoolBuilder()

+ .nodeUrls(Collections.singletonList(LOCAL_URL))

+ .user("root")

+ .password("root")

+ .maxSize(1)

+ .build();

+

+ try (ITableSession session = tableSessionPool.getSession()) {

+

+ session.executeNonQueryStatement("CREATE DATABASE test1");

+ session.executeNonQueryStatement("CREATE DATABASE test2");

+

+ session.executeNonQueryStatement("use test2");

+

+ // or use full qualified table name

+ session.executeNonQueryStatement(

+ "create table test1.table1("

+ + "region_id STRING ID, "

+ + "plant_id STRING ID, "

+ + "device_id STRING ID, "

+ + "model STRING ATTRIBUTE, "

+ + "temperature FLOAT MEASUREMENT, "

+ + "humidity DOUBLE MEASUREMENT) with (TTL=3600000)");

+

+ session.executeNonQueryStatement(

+ "create table table2("

+ + "region_id STRING ID, "

+ + "plant_id STRING ID, "

+ + "color STRING ATTRIBUTE, "

+ + "temperature FLOAT MEASUREMENT, "

+ + "speed DOUBLE MEASUREMENT) with (TTL=6600000)");

+

+ // show tables from current database

+ try (SessionDataSet dataSet = session.executeQueryStatement("SHOW TABLES")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ // show tables by specifying another database

+ // using SHOW tables FROM

+ try (SessionDataSet dataSet = session.executeQueryStatement("SHOW TABLES FROM test1")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ // insert table data by tablet

+ List measurementSchemaList =

+ new ArrayList<>(

+ Arrays.asList(

+ new MeasurementSchema("region_id", TSDataType.STRING),

+ new MeasurementSchema("plant_id", TSDataType.STRING),

+ new MeasurementSchema("device_id", TSDataType.STRING),

+ new MeasurementSchema("model", TSDataType.STRING),

+ new MeasurementSchema("temperature", TSDataType.FLOAT),

+ new MeasurementSchema("humidity", TSDataType.DOUBLE)));

+ List columnTypeList =

+ new ArrayList<>(

+ Arrays.asList(

+ ColumnCategory.ID,

+ ColumnCategory.ID,

+ ColumnCategory.ID,

+ ColumnCategory.ATTRIBUTE,

+ ColumnCategory.MEASUREMENT,

+ ColumnCategory.MEASUREMENT));

+ Tablet tablet =

+ new Tablet(

+ "test1",

+ IMeasurementSchema.getMeasurementNameList(measurementSchemaList),

+ IMeasurementSchema.getDataTypeList(measurementSchemaList),

+ columnTypeList,

+ 100);

+ for (long timestamp = 0; timestamp < 100; timestamp++) {

+ int rowIndex = tablet.getRowSize();

+ tablet.addTimestamp(rowIndex, timestamp);

+ tablet.addValue("region_id", rowIndex, "1");

+ tablet.addValue("plant_id", rowIndex, "5");

+ tablet.addValue("device_id", rowIndex, "3");

+ tablet.addValue("model", rowIndex, "A");

+ tablet.addValue("temperature", rowIndex, 37.6F);

+ tablet.addValue("humidity", rowIndex, 111.1);

+ if (tablet.getRowSize() == tablet.getMaxRowNumber()) {

+ session.insert(tablet);

+ tablet.reset();

+ }

+ }

+ if (tablet.getRowSize() != 0) {

+ session.insert(tablet);

+ tablet.reset();

+ }

+

+ // query table data

+ try (SessionDataSet dataSet =

+ session.executeQueryStatement(

+ "select * from test1 "

+ + "where region_id = '1' and plant_id in ('3', '5') and device_id = '3'")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ } catch (IoTDBConnectionException e) {

+ e.printStackTrace();

+ } catch (StatementExecutionException e) {

+ e.printStackTrace();

+ } finally {

+ tableSessionPool.close();

+ }

+

+ // specify database in constructor

+ tableSessionPool =

+ new TableSessionPoolBuilder()

+ .nodeUrls(Collections.singletonList(LOCAL_URL))

+ .user("root")

+ .password("root")

+ .maxSize(1)

+ .database("test1")

+ .build();

+

+ try (ITableSession session = tableSessionPool.getSession()) {

+

+ // show tables from current database

+ try (SessionDataSet dataSet = session.executeQueryStatement("SHOW TABLES")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ // change database to test2

+ session.executeNonQueryStatement("use test2");

+

+ // show tables by specifying another database

+ // using SHOW tables FROM

+ try (SessionDataSet dataSet = session.executeQueryStatement("SHOW TABLES")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ } catch (IoTDBConnectionException e) {

+ e.printStackTrace();

+ } catch (StatementExecutionException e) {

+ e.printStackTrace();

+ }

+

+ try (ITableSession session = tableSessionPool.getSession()) {

+

+ // show tables from default database test1

+ try (SessionDataSet dataSet = session.executeQueryStatement("SHOW TABLES")) {

+ System.out.println(dataSet.getColumnNames());

+ System.out.println(dataSet.getColumnTypes());

+ while (dataSet.hasNext()) {

+ System.out.println(dataSet.next());

+ }

+ }

+

+ } catch (IoTDBConnectionException e) {

+ e.printStackTrace();

+ } catch (StatementExecutionException e) {

+ e.printStackTrace();

+ } finally {

+ tableSessionPool.close();

+ }

+ }

+}

+```

\ No newline at end of file

diff --git a/src/zh/UserGuide/Master/Table/API/Programming-Python-Native-API.md b/src/zh/UserGuide/Master/Table/API/Programming-Python-Native-API.md

new file mode 100644

index 000000000..28f92880a

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/API/Programming-Python-Native-API.md

@@ -0,0 +1,457 @@

+

+

+# Python 原生接口

+

+## 1 使用方式

+

+安装依赖包:

+

+```Java

+pip3 install apache-iotdb

+```

+

+## 2 读写操作

+

+### 2.1 TableSession

+

+#### 2.1.1 功能描述

+

+TableSession是IoTDB的一个核心类,用于与IoTDB数据库进行交互。通过这个类,用户可以执行SQL语句、插入数据以及管理数据库会话。

+

+#### 2.1.2 方法列表

+

+| **方法名称** | **描述** | **参数类型** | **返回类型** |

+| --------------------------- | ---------------------------------- | ---------------------------------- | -------------- |

+| insert | 写入数据 | tablet: Union[Tablet, NumpyTablet] | None |

+| execute_non_query_statement | 执行非查询 SQL 语句,如 DDL 和 DML | sql: str | None |

+| execute_query_statement | 执行查询 SQL 语句并返回结果集 | sql: str | SessionDataSet |

+| close | 关闭会话并释放资源 | None | None |

+

+#### 2.1.3 接口展示

+

+**TableSession:**

+

+

+```Java

+class TableSession(object):

+def insert(self, tablet: Union[Tablet, NumpyTablet]):

+ """

+ Insert data into the database.

+

+ Parameters:

+ tablet (Tablet | NumpyTablet): The tablet containing the data to be inserted.

+ Accepts either a `Tablet` or `NumpyTablet`.

+

+ Raises:

+ IoTDBConnectionException: If there is an issue with the database connection.

+ """

+ pass

+

+def execute_non_query_statement(self, sql: str):

+ """

+ Execute a non-query SQL statement.

+

+ Parameters:

+ sql (str): The SQL statement to execute. Typically used for commands

+ such as INSERT, DELETE, or UPDATE.

+

+ Raises:

+ IoTDBConnectionException: If there is an issue with the database connection.

+ """

+ pass

+

+def execute_query_statement(self, sql: str, timeout_in_ms: int = 0) -> "SessionDataSet":

+ """

+ Execute a query SQL statement and return the result set.

+

+ Parameters:

+ sql (str): The SQL query to execute.

+ timeout_in_ms (int, optional): Timeout for the query in milliseconds. Defaults to 0,

+ which means no timeout.

+

+ Returns:

+ SessionDataSet: The result set of the query.

+

+ Raises:

+ IoTDBConnectionException: If there is an issue with the database connection.

+ """

+ pass

+

+def close(self):

+ """

+ Close the session and release resources.

+

+ Raises:

+ IoTDBConnectionException: If there is an issue closing the connection.

+ """

+ pass

+```

+

+### 2.2 TableSessionConfig

+

+#### 2.2.1 功能描述

+

+TableSessionConfig是一个配置类,用于设置和创建TableSession 实例。它定义了连接到IoTDB数据库所需的各种参数。

+

+#### 2.2.2 配置选项

+

+| **配置项** | **描述** | **类型** | **默认值** |

+| ------------------ | ------------------------- | -------- | ----------------------- |

+| node_urls | 数据库连接的节点 URL 列表 | list | ["localhost:6667"] |

+| username | 数据库连接用户名 | str | "root" |

+| password | 数据库连接密码 | str | "root" |

+| database | 要连接的目标数据库 | str | None |

+| fetch_size | 每次查询获取的行数 | int | 5000 |

+| time_zone | 会话的默认时区 | str | Session.DEFAULT_ZONE_ID |

+| enable_compression | 是否启用数据压缩 | bool | False |

+

+#### 2.2.3 接口展示

+

+```Java

+class TableSessionConfig(object):

+ """

+ Configuration class for a TableSession.

+

+ This class defines various parameters for connecting to and interacting

+ with the IoTDB tables.

+ """

+

+ def __init__(

+ self,

+ node_urls: list = None,

+ username: str = Session.DEFAULT_USER,

+ password: str = Session.DEFAULT_PASSWORD,

+ database: str = None,

+ fetch_size: int = 5000,

+ time_zone: str = Session.DEFAULT_ZONE_ID,

+ enable_compression: bool = False,

+ ):

+ """

+ Initialize a TableSessionConfig object with the provided parameters.

+

+ Parameters:

+ node_urls (list, optional): A list of node URLs for the database connection.

+ Defaults to ["localhost:6667"].

+ username (str, optional): The username for the database connection.

+ Defaults to "root".

+ password (str, optional): The password for the database connection.

+ Defaults to "root".

+ database (str, optional): The target database to connect to. Defaults to None.

+ fetch_size (int, optional): The number of rows to fetch per query. Defaults to 5000.

+ time_zone (str, optional): The default time zone for the session.

+ Defaults to Session.DEFAULT_ZONE_ID.

+ enable_compression (bool, optional): Whether to enable data compression.

+ Defaults to False.

+ """

+```

+

+**注意事项:**

+

+在使用完 TableSession 后,务必调用 close 方法来释放资源。

+

+## 3 客户端连接池

+

+### 3.1 TableSessionPool

+

+#### 3.1.1 功能描述

+

+TableSessionPool 是一个会话池管理类,用于管理 TableSession 实例的创建和销毁。它提供了从池中获取会话和关闭会话池的功能。

+

+#### 3.1.2 方法列表

+

+| **方法名称** | **描述** | **返回类型** | **异常** |

+| ------------ | ---------------------------------------- | ------------ | -------- |

+| get_session | 从会话池中检索一个新的 TableSession 实例 | TableSession | 无 |

+| close | 关闭会话池并释放所有资源 | None | 无 |

+

+#### 3.1.3 接口展示

+

+**TableSessionPool:**

+

+```Java

+def get_session(self) -> TableSession:

+ """

+ Retrieve a new TableSession instance.

+

+ Returns:

+ TableSession: A new session object configured with the session pool.

+

+ Notes:

+ The session is initialized with the underlying session pool for managing

+ connections. Ensure proper usage of the session's lifecycle.

+ """

+

+def close(self):

+ """

+ Close the session pool and release all resources.

+

+ This method closes the underlying session pool, ensuring that all

+ resources associated with it are properly released.

+

+ Notes:

+ After calling this method, the session pool cannot be used to retrieve

+ new sessions, and any attempt to do so may raise an exception.

+ """

+```

+

+### 3.2 TableSessionPoolConfig

+

+#### 3.2.1 功能描述

+

+TableSessionPoolConfig是一个配置类,用于设置和创建 TableSessionPool 实例。它定义了初始化和管理 IoTDB 数据库会话池所需的参数。

+

+#### 3.2.2 配置选项

+

+| **配置项** | **描述** | **类型** | **默认值** |

+| ------------------ | ------------------------------ | -------- | ------------------------ |

+| node_urls | 数据库连接的节点 URL 列表 | list | None |

+| max_pool_size | 会话池中的最大会话数 | int | 5 |

+| username | 数据库连接用户名 | str | Session.DEFAULT_USER |

+| password | 数据库连接密码 | str | Session.DEFAULT_PASSWORD |

+| database | 要连接的目标数据库 | str | None |

+| fetch_size | 每次查询获取的行数 | int | 5000 |

+| time_zone | 会话池的默认时区 | str | Session.DEFAULT_ZONE_ID |

+| enable_redirection | 是否启用重定向 | bool | False |

+| enable_compression | 是否启用数据压缩 | bool | False |

+| wait_timeout_in_ms | 等待会话可用的最大时间(毫秒) | int | 10000 |

+| max_retry | 操作的最大重试次数 | int | 3 |

+

+#### 3.2.3 接口展示

+

+

+```Java

+class TableSessionPoolConfig(object):

+ """

+ Configuration class for a TableSessionPool.

+

+ This class defines the parameters required to initialize and manage

+ a session pool for interacting with the IoTDB database.

+ """

+ def __init__(

+ self,

+ node_urls: list = None,

+ max_pool_size: int = 5,

+ username: str = Session.DEFAULT_USER,

+ password: str = Session.DEFAULT_PASSWORD,

+ database: str = None,

+ fetch_size: int = 5000,

+ time_zone: str = Session.DEFAULT_ZONE_ID,

+ enable_redirection: bool = False,

+ enable_compression: bool = False,

+ wait_timeout_in_ms: int = 10000,

+ max_retry: int = 3,

+ ):

+ """

+ Initialize a TableSessionPoolConfig object with the provided parameters.

+

+ Parameters:

+ node_urls (list, optional): A list of node URLs for the database connection.

+ Defaults to None.

+ max_pool_size (int, optional): The maximum number of sessions in the pool.

+ Defaults to 5.

+ username (str, optional): The username for the database connection.

+ Defaults to Session.DEFAULT_USER.

+ password (str, optional): The password for the database connection.

+ Defaults to Session.DEFAULT_PASSWORD.

+ database (str, optional): The target database to connect to. Defaults to None.

+ fetch_size (int, optional): The number of rows to fetch per query. Defaults to 5000.

+ time_zone (str, optional): The default time zone for the session pool.

+ Defaults to Session.DEFAULT_ZONE_ID.

+ enable_redirection (bool, optional): Whether to enable redirection.

+ Defaults to False.

+ enable_compression (bool, optional): Whether to enable data compression.

+ Defaults to False.

+ wait_timeout_in_ms (int, optional): The maximum time (in milliseconds) to wait for a session

+ to become available. Defaults to 10000.

+ max_retry (int, optional): The maximum number of retry attempts for operations. Defaults to 3.

+

+ """

+```

+

+## 4 示例代码

+

+Session示例代码:[iotdb/blob/master/iotdb-client/client-py/table_model_session_example.py](https://github.com/apache/iotdb/blob/master/iotdb-client/client-py/table_model_session_example.py)

+

+SessionPool示例代码:[iotdb/blob/master/iotdb-client/client-py/table_model_session_pool_example.py](https://github.com/apache/iotdb/blob/master/iotdb-client/client-py/table_model_session_pool_example.py)

+

+```Java

+# Licensed to the Apache Software Foundation (ASF) under one

+# or more contributor license agreements. See the NOTICE file

+# distributed with this work for additional information

+# regarding copyright ownership. The ASF licenses this file

+# to you under the Apache License, Version 2.0 (the

+# "License"); you may not use this file except in compliance

+# with the License. You may obtain a copy of the License at

+#

+# http://www.apache.org/licenses/LICENSE-2.0

+#

+# Unless required by applicable law or agreed to in writing,

+# software distributed under the License is distributed on an

+# "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

+# KIND, either express or implied. See the License for the

+# specific language governing permissions and limitations

+# under the License.

+#

+import threading

+

+import numpy as np

+

+from iotdb.table_session_pool import TableSessionPool, TableSessionPoolConfig

+from iotdb.utils.IoTDBConstants import TSDataType

+from iotdb.utils.NumpyTablet import NumpyTablet

+from iotdb.utils.Tablet import ColumnType, Tablet

+

+

+def prepare_data():

+ print("create database")

+ # Get a session from the pool

+ session = session_pool.get_session()

+ session.execute_non_query_statement("CREATE DATABASE IF NOT EXISTS db1")

+ session.execute_non_query_statement('USE "db1"')

+ session.execute_non_query_statement(

+ "CREATE TABLE table0 (id1 string id, attr1 string attribute, "

+ + "m1 double "

+ + "measurement)"

+ )

+ session.execute_non_query_statement(

+ "CREATE TABLE table1 (id1 string id, attr1 string attribute, "

+ + "m1 double "

+ + "measurement)"

+ )

+

+ print("now the tables are:")

+ # show result

+ res = session.execute_query_statement("SHOW TABLES")

+ while res.has_next():

+ print(res.next())

+

+ session.close()

+

+

+def insert_data(num: int):

+ print("insert data for table" + str(num))

+ # Get a session from the pool

+ session = session_pool.get_session()

+ column_names = [

+ "id1",

+ "attr1",

+ "m1",

+ ]

+ data_types = [

+ TSDataType.STRING,

+ TSDataType.STRING,

+ TSDataType.DOUBLE,

+ ]

+ column_types = [ColumnType.ID, ColumnType.ATTRIBUTE, ColumnType.MEASUREMENT]

+ timestamps = []

+ values = []

+ for row in range(15):

+ timestamps.append(row)

+ values.append(["id:" + str(row), "attr:" + str(row), row * 1.0])

+ tablet = Tablet(

+ "table" + str(num), column_names, data_types, values, timestamps, column_types

+ )

+ session.insert(tablet)

+ session.execute_non_query_statement("FLush")

+

+ np_timestamps = np.arange(15, 30, dtype=np.dtype(">i8"))

+ np_values = [

+ np.array(["id:{}".format(i) for i in range(15, 30)]),

+ np.array(["attr:{}".format(i) for i in range(15, 30)]),

+ np.linspace(15.0, 29.0, num=15, dtype=TSDataType.DOUBLE.np_dtype()),

+ ]

+

+ np_tablet = NumpyTablet(

+ "table" + str(num),

+ column_names,

+ data_types,

+ np_values,

+ np_timestamps,

+ column_types=column_types,

+ )

+ session.insert(np_tablet)

+ session.close()

+

+

+def query_data():

+ # Get a session from the pool

+ session = session_pool.get_session()

+

+ print("get data from table0")

+ res = session.execute_query_statement("select * from table0")

+ while res.has_next():

+ print(res.next())

+

+ print("get data from table1")

+ res = session.execute_query_statement("select * from table0")

+ while res.has_next():

+ print(res.next())

+

+ session.close()

+

+

+def delete_data():

+ session = session_pool.get_session()

+ session.execute_non_query_statement("drop database db1")

+ print("data has been deleted. now the databases are:")

+ res = session.execute_query_statement("show databases")

+ while res.has_next():

+ print(res.next())

+ session.close()

+

+

+# Create a session pool

+username = "root"

+password = "root"

+node_urls = ["127.0.0.1:6667", "127.0.0.1:6668", "127.0.0.1:6669"]

+fetch_size = 1024

+database = "db1"

+max_pool_size = 5

+wait_timeout_in_ms = 3000

+config = TableSessionPoolConfig(

+ node_urls=node_urls,

+ username=username,

+ password=password,

+ database=database,

+ max_pool_size=max_pool_size,

+ fetch_size=fetch_size,

+ wait_timeout_in_ms=wait_timeout_in_ms,

+)

+session_pool = TableSessionPool(config)

+

+prepare_data()

+

+insert_thread1 = threading.Thread(target=insert_data, args=(0,))

+insert_thread2 = threading.Thread(target=insert_data, args=(1,))

+

+insert_thread1.start()

+insert_thread2.start()

+

+insert_thread1.join()

+insert_thread2.join()

+

+query_data()

+delete_data()

+session_pool.close()

+print("example is finished!")

+```

+

diff --git a/src/zh/UserGuide/Master/Table/Background-knowledge/Cluster-Concept.md b/src/zh/UserGuide/Master/Table/Background-knowledge/Cluster-Concept.md

new file mode 100644

index 000000000..ebd6a800e

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/Background-knowledge/Cluster-Concept.md

@@ -0,0 +1,55 @@

+

+

+# 集群相关概念

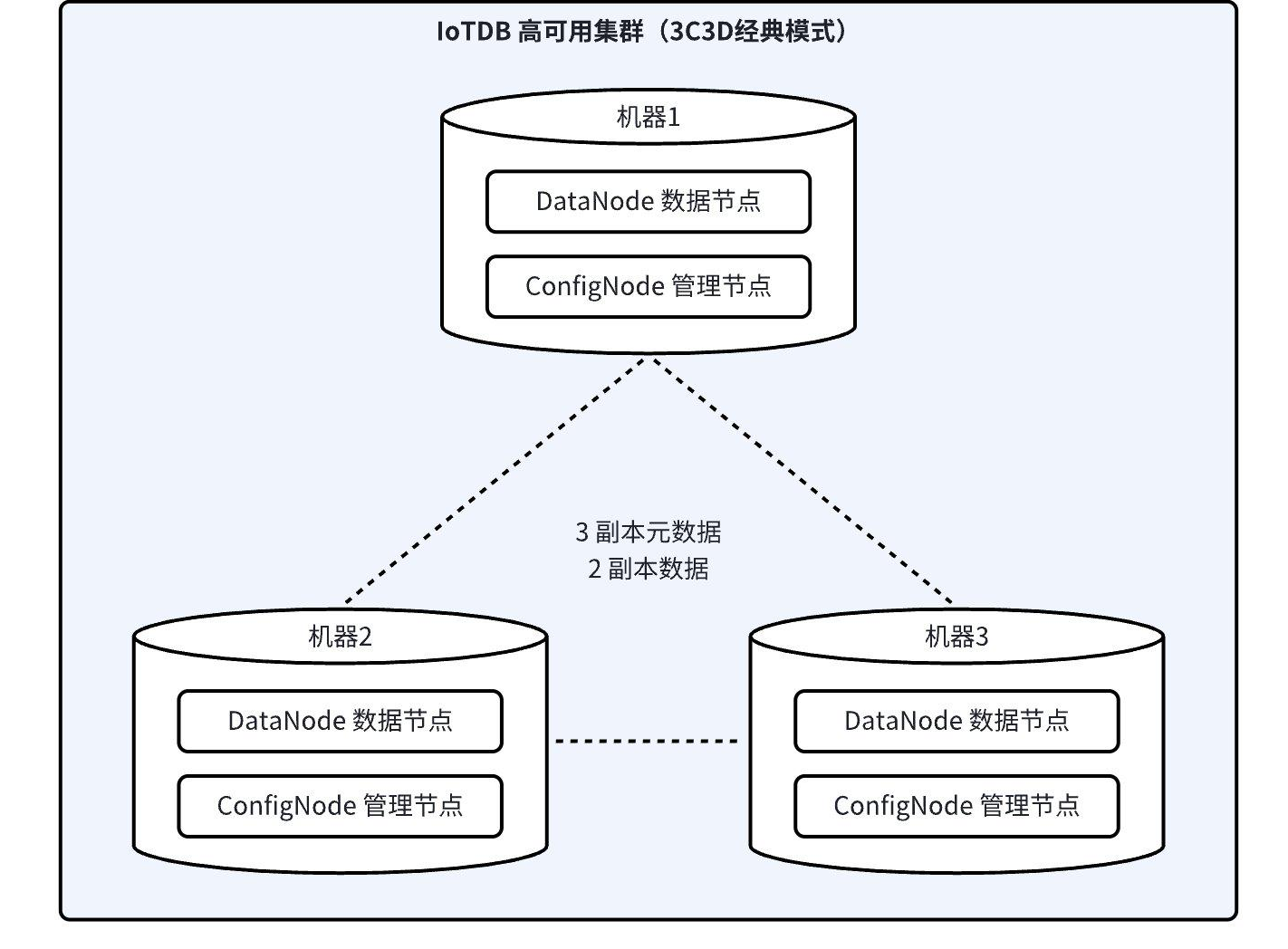

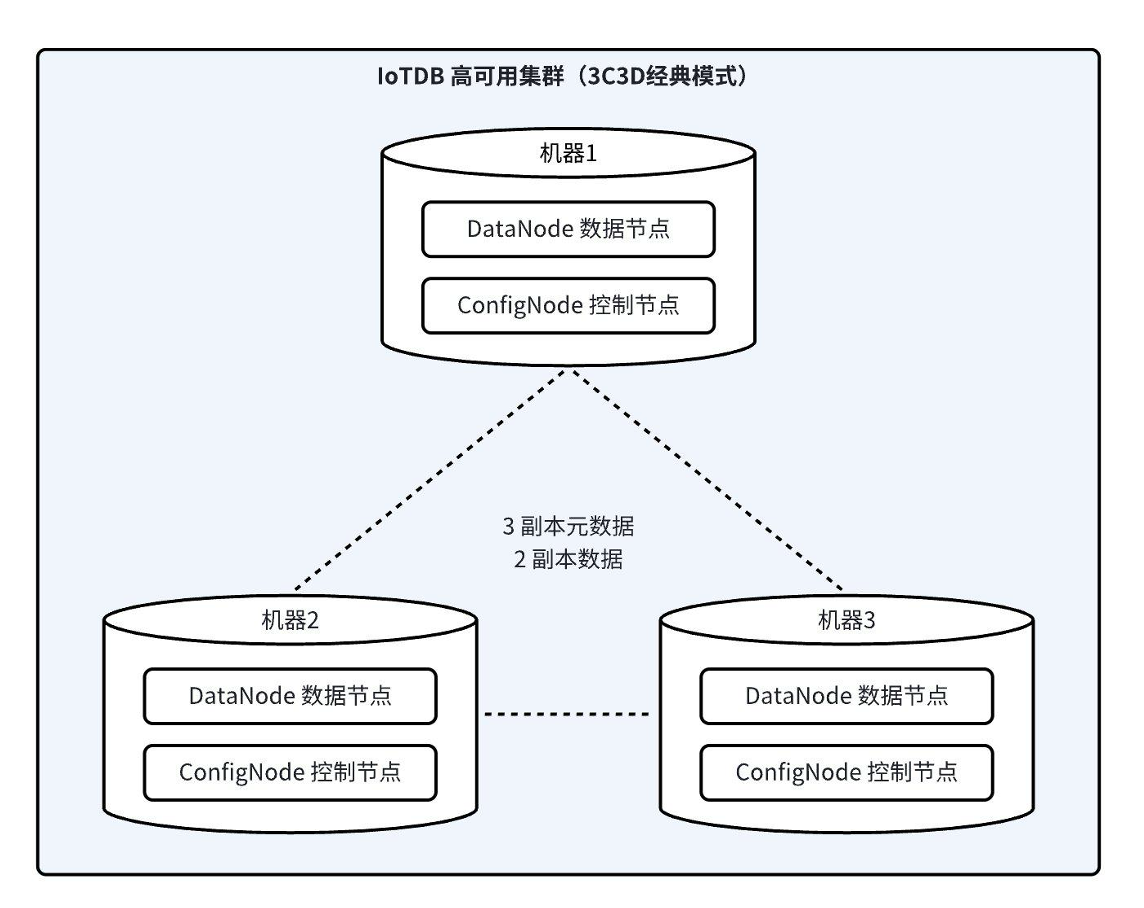

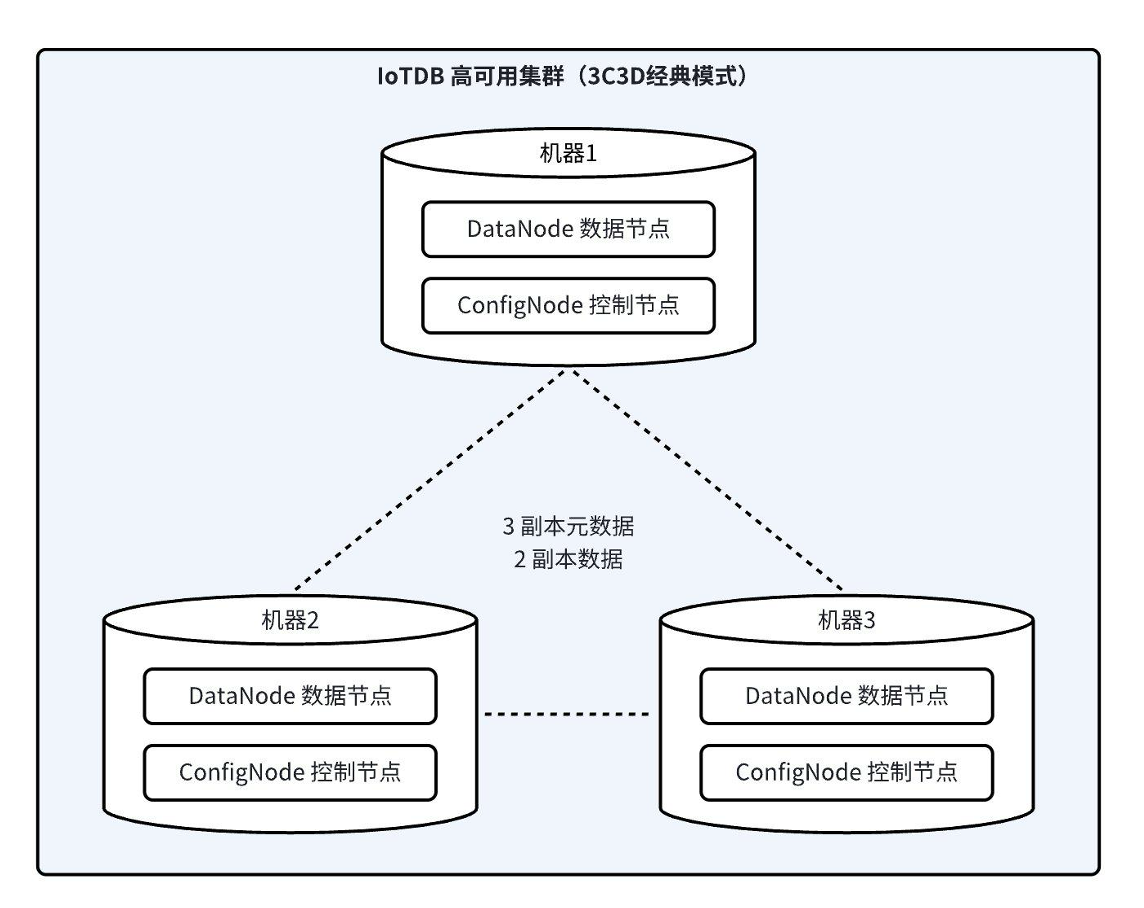

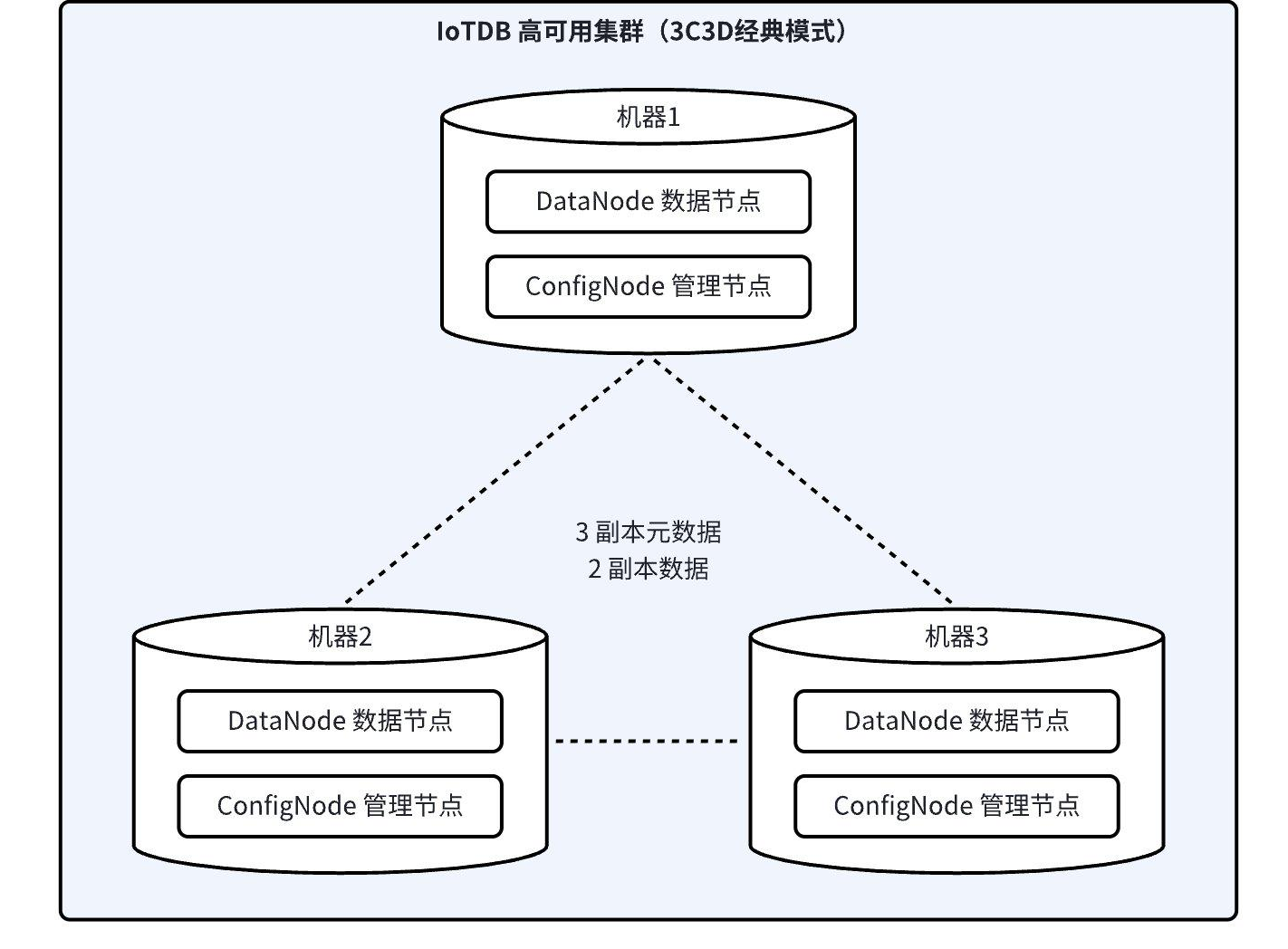

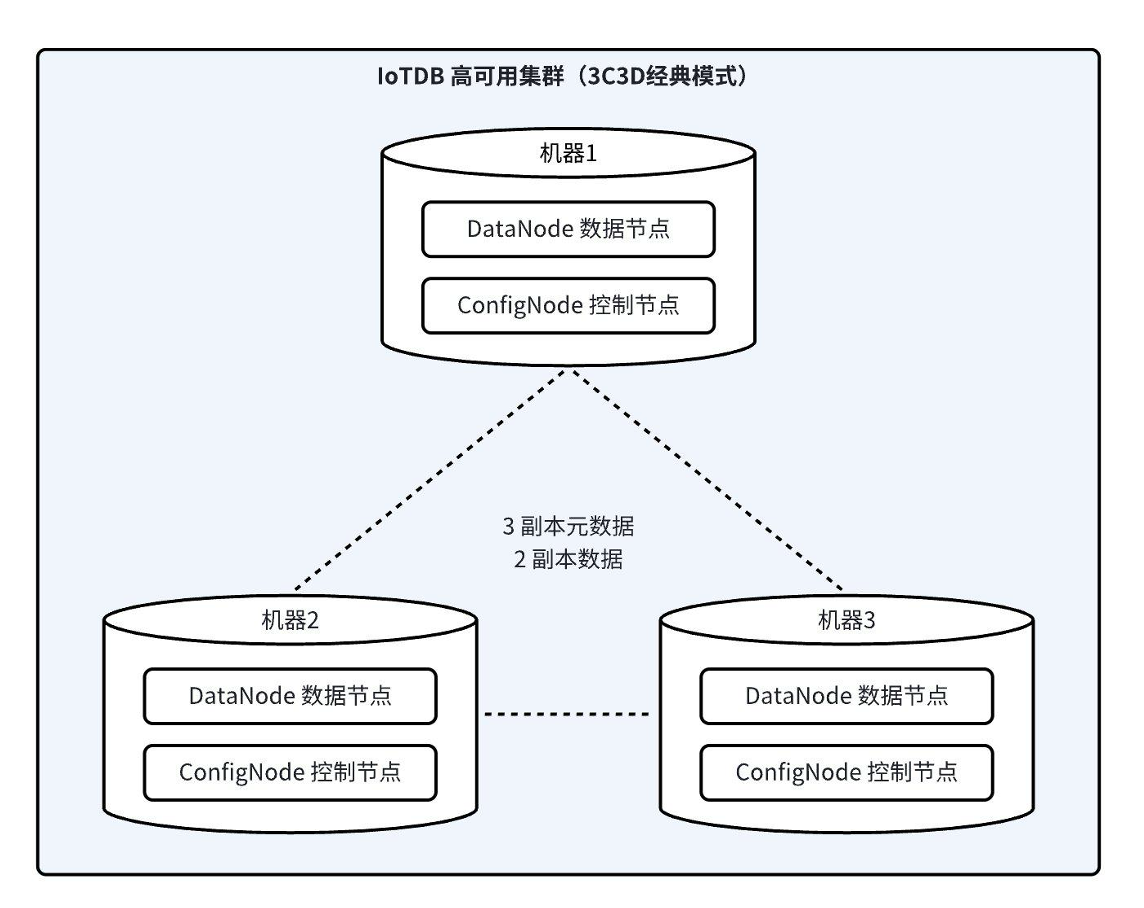

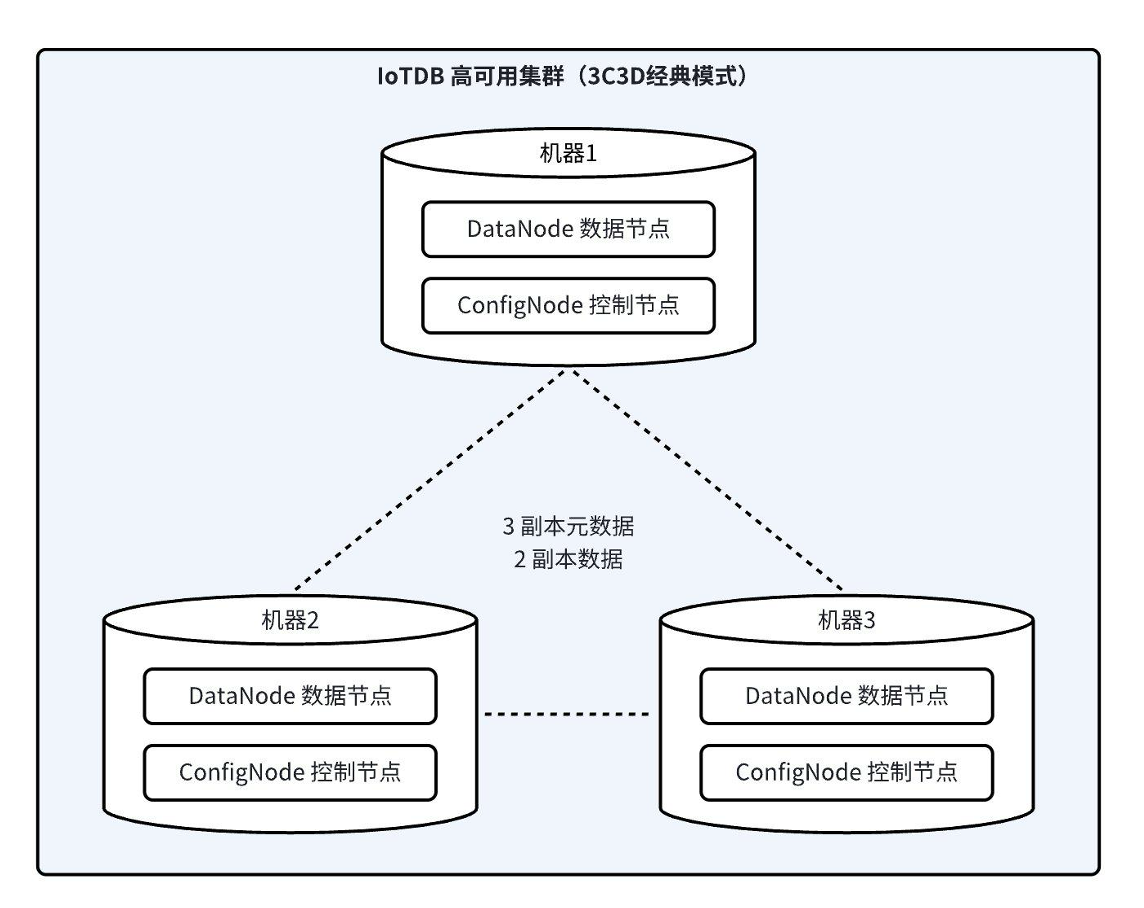

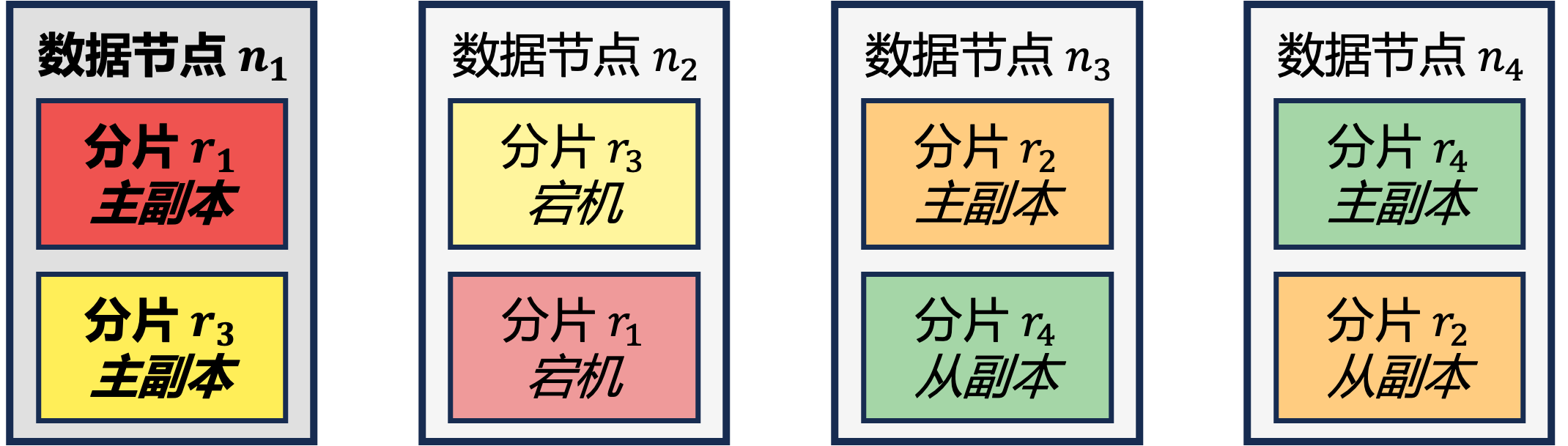

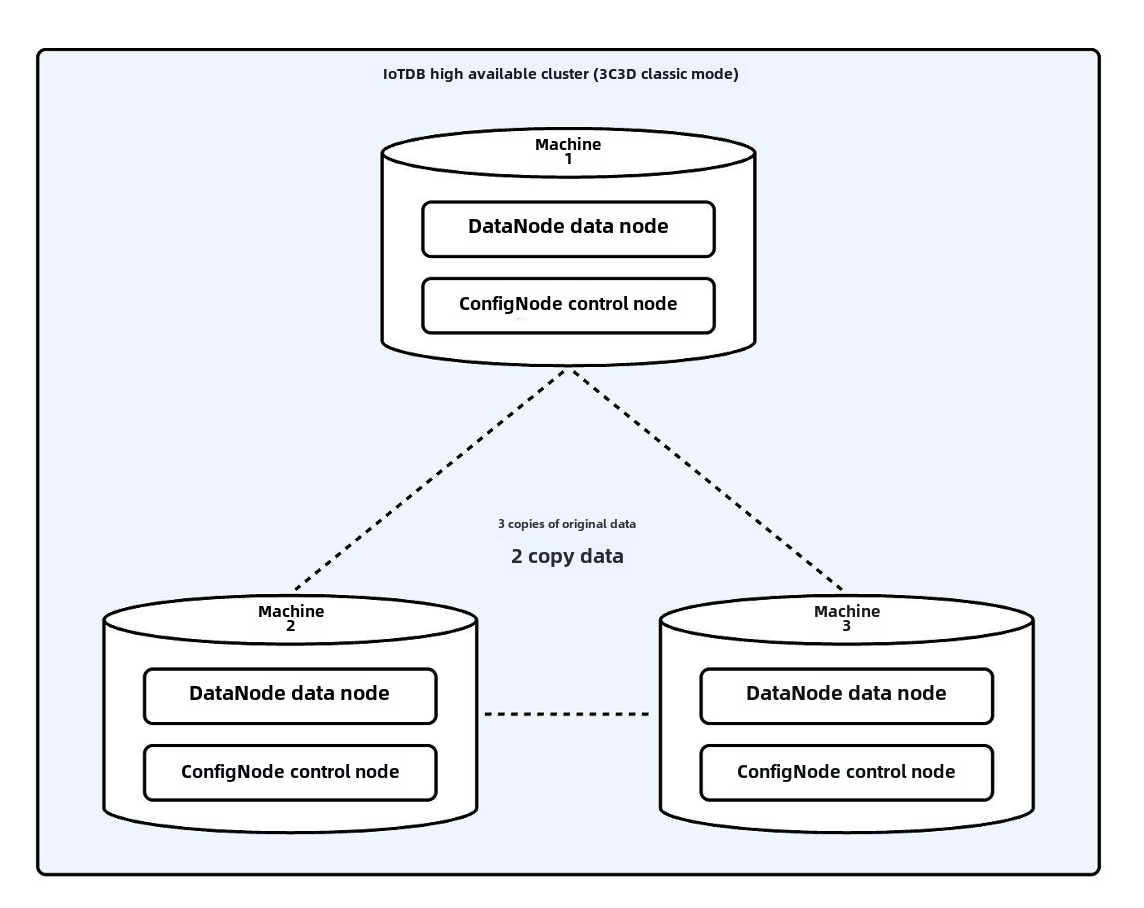

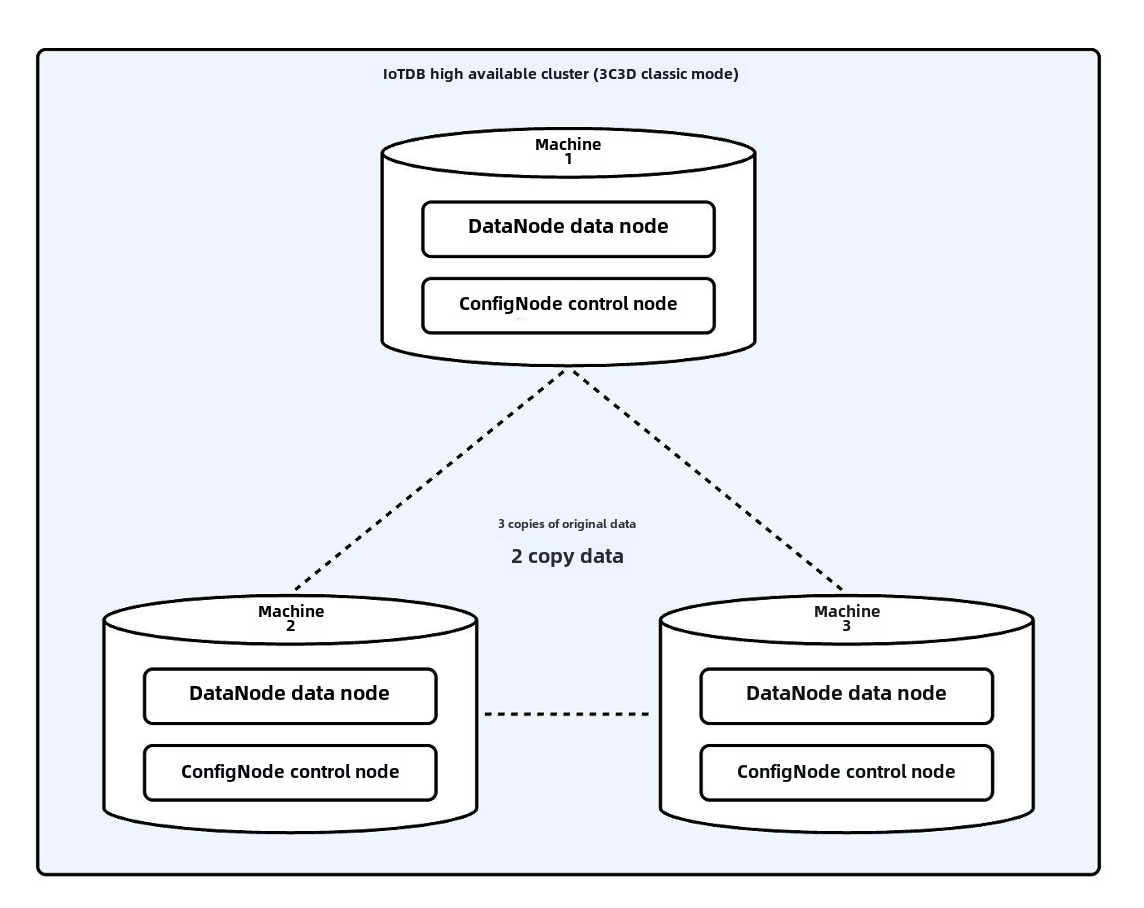

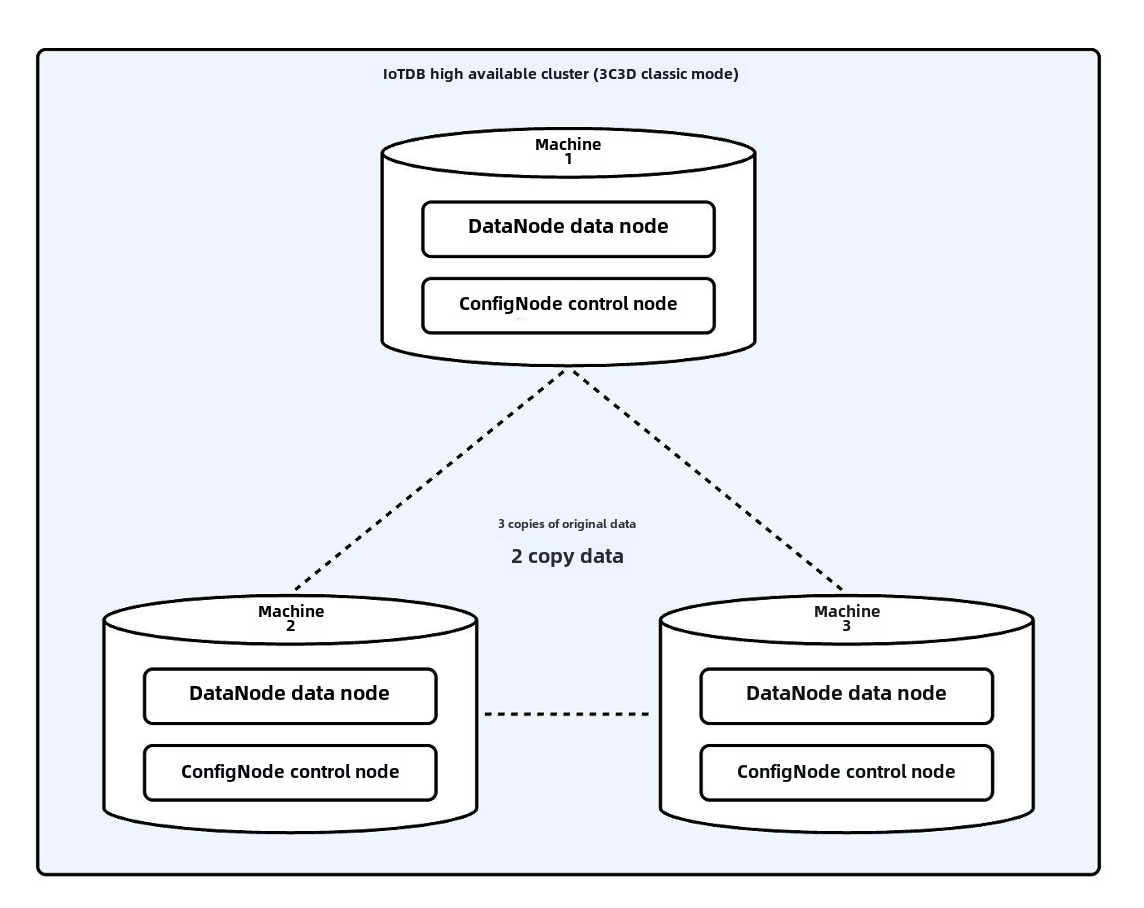

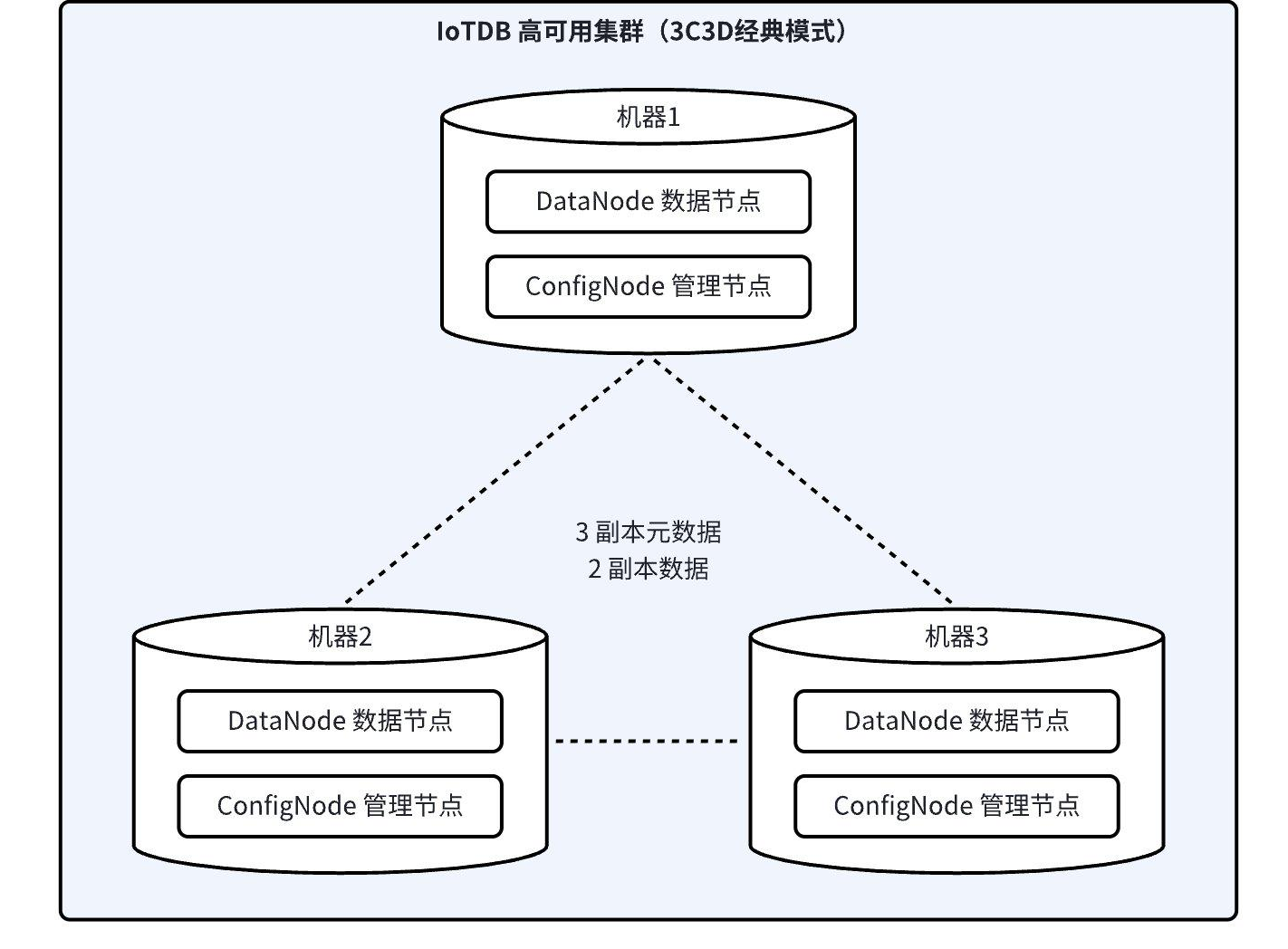

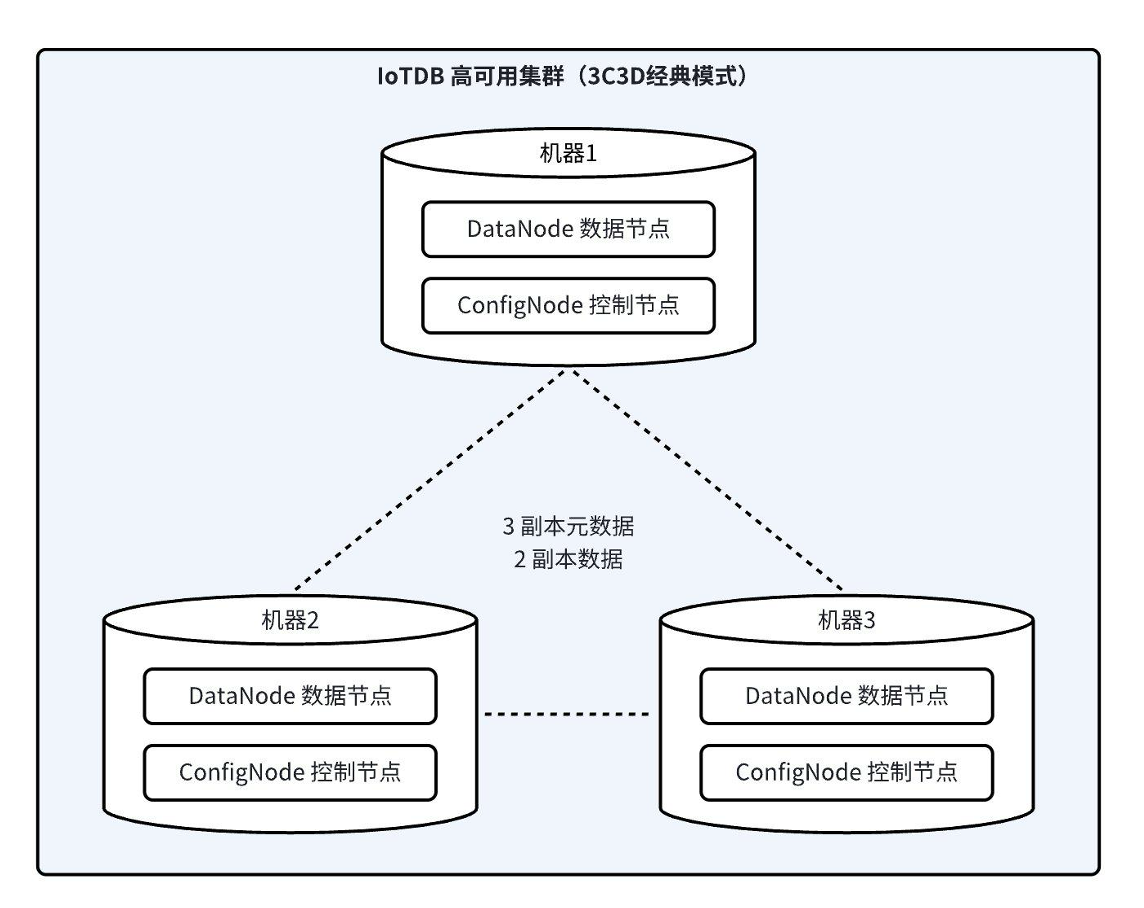

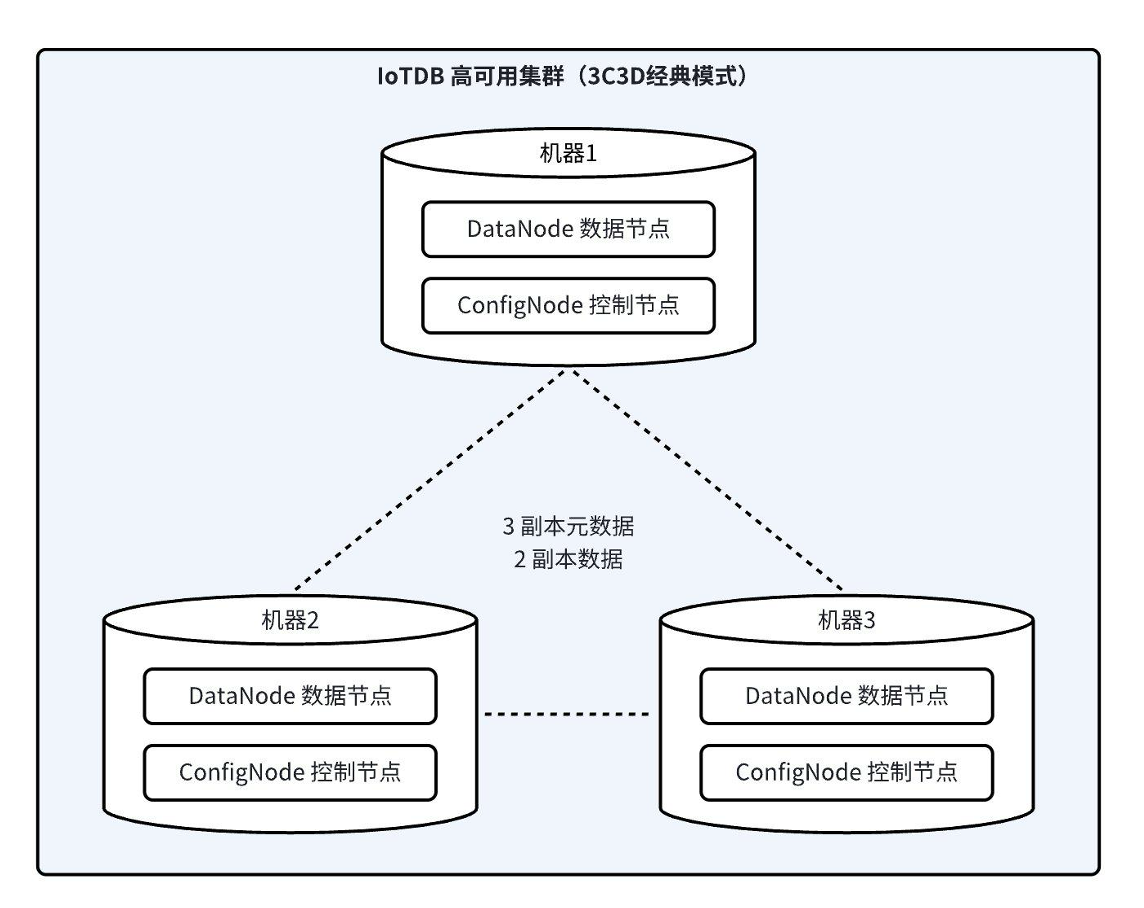

+下图展示了一个常见的 IoTDB 3C3D1A(3 个 ConfigNode、3 个 DataNode 和 1 个 AINode)的集群部署模式:

+ +

+其中包括了 IoTDB 集群使用中用户常接触到的几个概念,包括:

+- **节点**(ConfigNode、DataNode、AINode);

+- **槽**(SchemaSlot、DataSlot);

+- **Region**(SchemaRegion、DataRegion);

+- ***副本组***。

+

+下文将重点对以上概念进行介绍。

+

+## 节点

+IoTDB 集群包括三种节点(进程),**ConfigNode**(管理节点),**DataNode**(数据节点)和 **AINode**(分析节点),如下所示:

+- **ConfigNode**:存储集群的配置信息、数据库的元数据、时间序列元数据和数据的路由信息,监控集群节点并实施负载均衡,所有 ConfigNode 之间互为全量备份,如上图中的 ConfigNode-1,ConfigNode-2 和 ConfigNode-3 所示。ConfigNode 不直接接收客户端读写请求,它会通过一系列[负载均衡算法](../Technical-Insider/Cluster-data-partitioning.md)对集群中元数据和数据的分布提供指导。

+- **DataNode**:负责时间序列元数据和数据的读写,每个 DataNode 都能接收客户端读写请求并提供相应服务,如上图中的 DataNode-1,DataNode-2 和 DataNode-3 所示。接收客户端读写请求时,若 DataNode 缓存有对应的路由信息,它能直接在本地执行或是转发这些请求;否则它会向 ConfigNode 询问并缓存路由信息,以加速后续请求的服务效率。

+- **AINode**:负责与 ConfigNode 和 DataNode 交互来扩展 IoTDB 集群对时间序列进行智能分析的能力,支持从外部引入已有机器学习模型进行注册,并使用注册的模型在指定时序数据上通过简单 SQL 语句完成时序分析任务的过程,将模型的创建、管理及推理融合在数据库引擎中。目前已提供常见时序分析场景(例如预测与异常检测)的机器学习算法或自研模型。

+

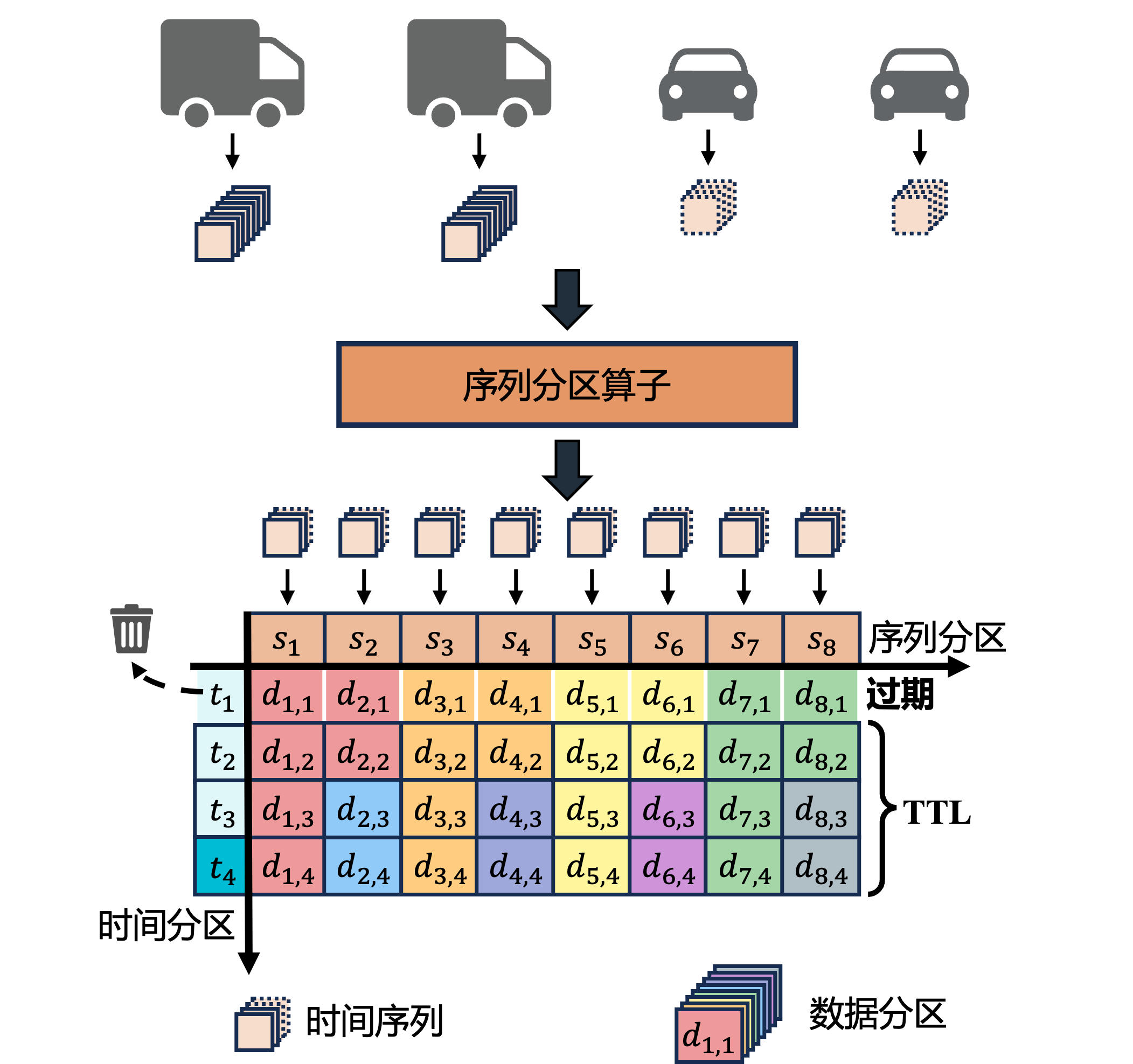

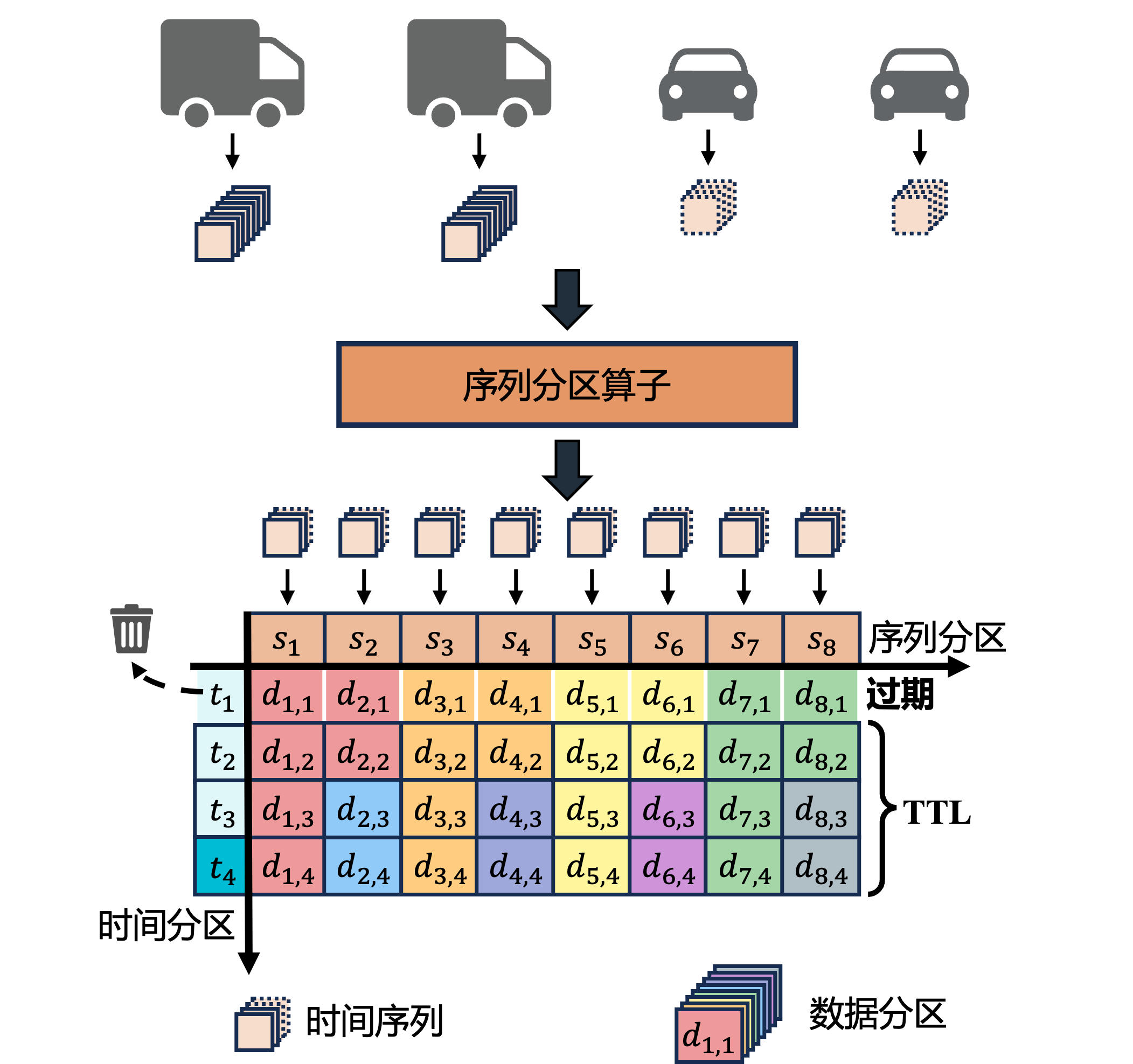

+## 槽

+IoTDB 内部将元数据和数据划分成多个更小的、更易于管理的单元,每个单元称为一个**槽**。槽是一个逻辑概念,在 IoTDB 集群中,**元数据槽**和**数据槽**定义如下:

+- **元数据槽**(SchemaSlot):一部分元数据集合,元数据槽总数固定,默认数量为 1000,IoTDB 使用哈希算法将所有设备均匀地分配到这些元数据槽中。

+- **数据槽**(DataSlot):一部分数据集合,在元数据槽的基础上,将对应设备的数据按时间范围划分为数据槽,默认的时间范围为 7 天。

+

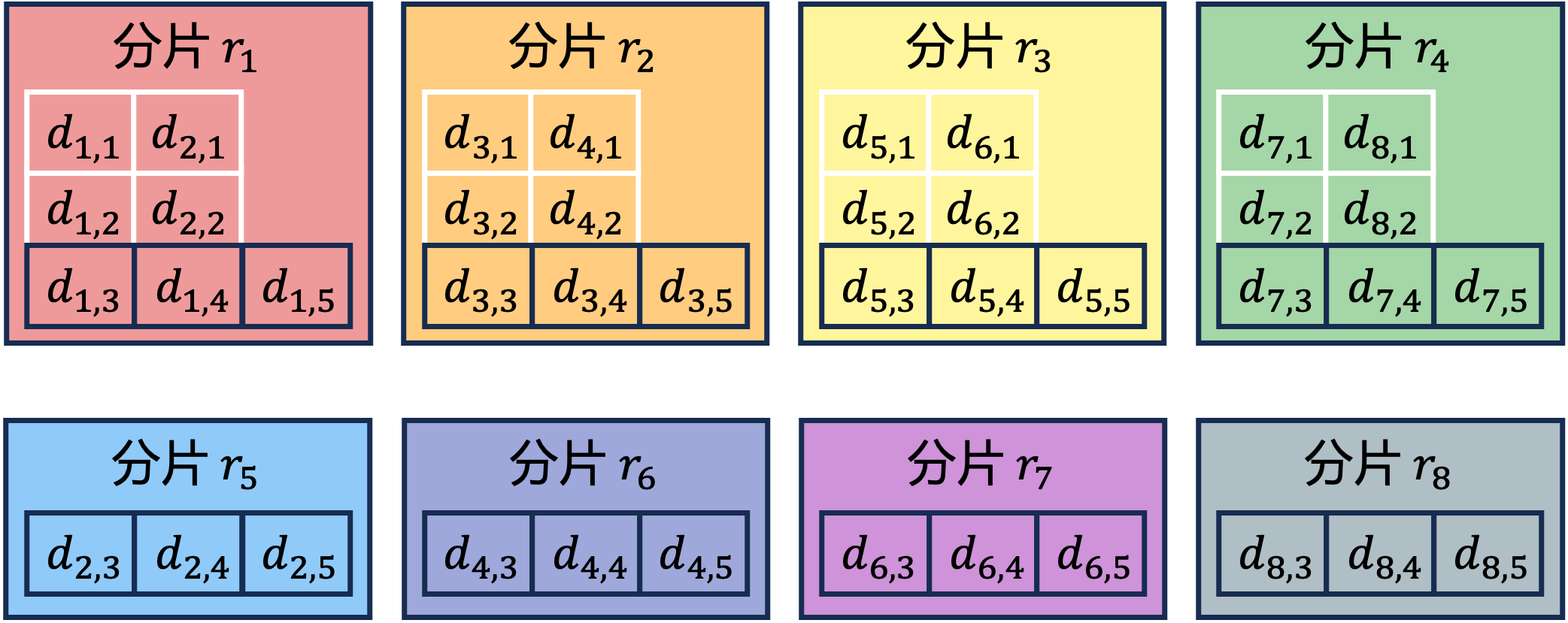

+## Region

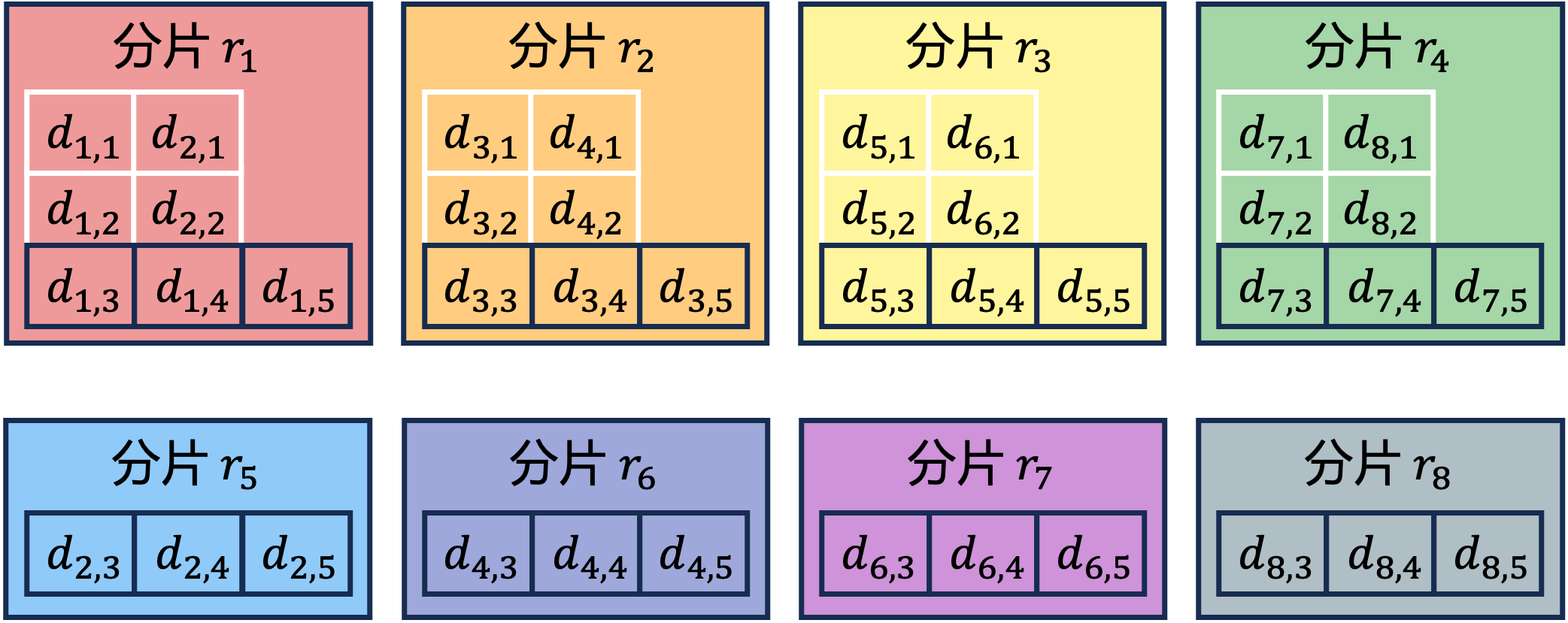

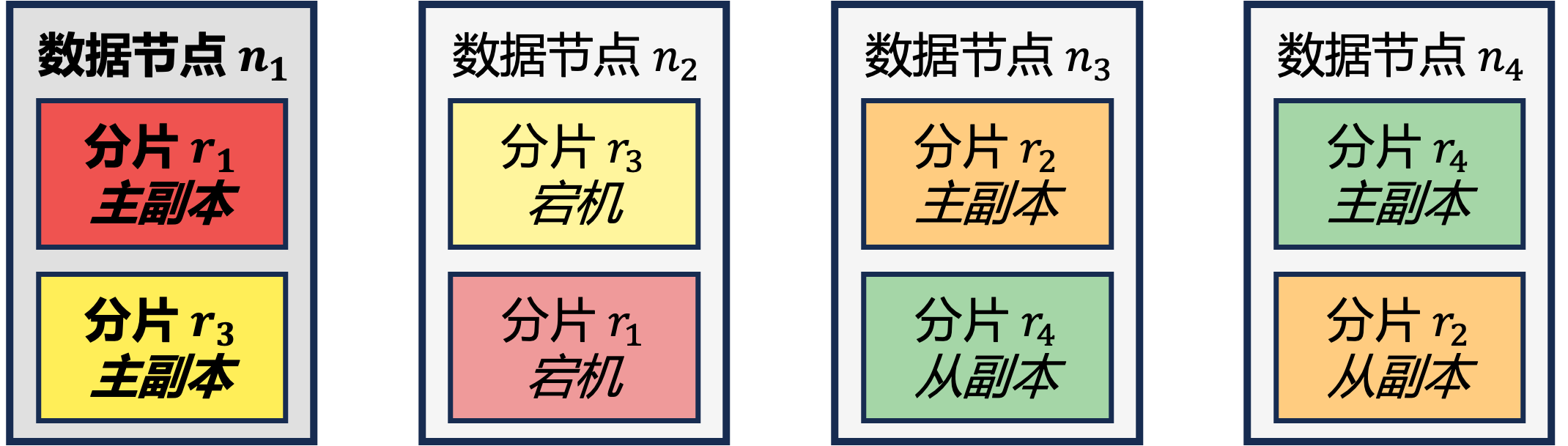

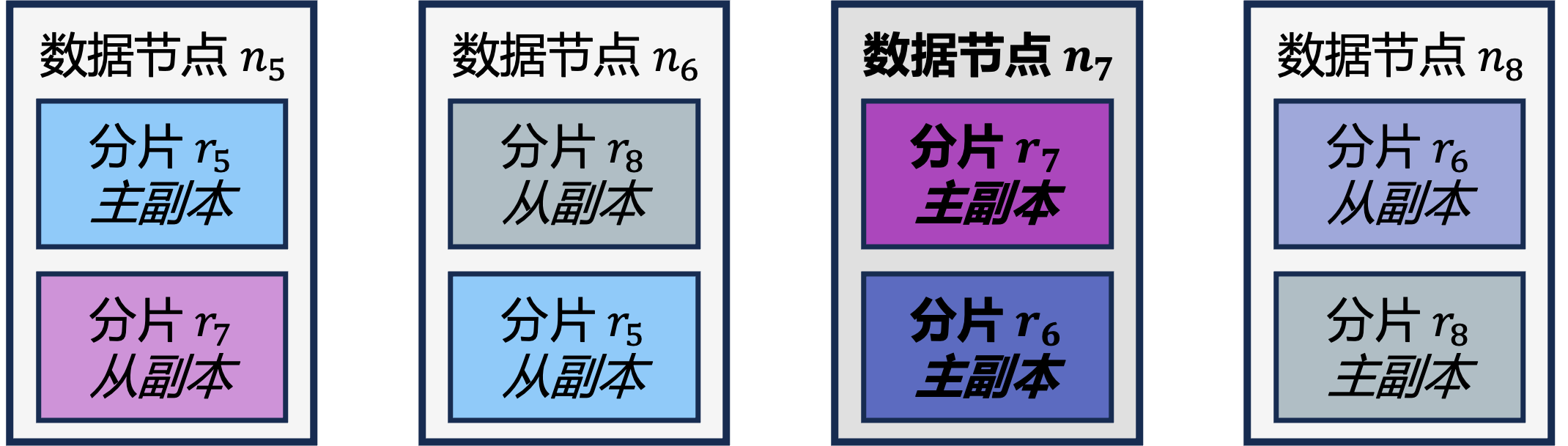

+在 IoTDB 中,元数据和数据被复制到各个 DataNode 以获得集群高可用性。然而以槽为粒度进行复制会增加集群管理成本、降低写入吞吐。因此 IoTDB 引入 **Region** 这一概念,将元数据槽和数据槽分别分配给 SchemaRegion 和 DataRegion 后,以 Region 为单位进行复制。**SchemRegion** 和 **DataRegion** 的详细定义如下:

+- **SchemaRegion**:元数据存储和复制的基本单元,集群每个数据库的所有元数据槽会被均匀分配给该数据库的所有 SchemaRegion。拥有相同 RegionID 的 SchemaRegion 互为副本,如上图中 SchemaRegion-1 拥有三个副本,分别放置于 DataNode-1,DataNode-2 和 DataNode-3。

+- **DataRegion**:数据存储和复制的基本单元,集群每个数据库的所有数据槽会被均匀分配给该数据库的所有 DataRegion。拥有相同 RegionID 的 DataRegion 互为副本,如上图中 DataRegion-2 拥有两个副本,分别放置于 DataNode-1 和 DataNode-2。

+

+## 副本组

+Region 的副本对集群的容灾能力至关重要。对于每个 Region 的所有副本,它们的角色分为 **leader** 和 **follower**,共同提供读写服务。不同架构下的副本组配置推荐如下:

+| 类别 | 配置项 | 单机推荐配置 | 分布式推荐配置 |

+| :-: | :-: | :-: | :-: |

+| 元数据 | schema_replication_factor | 1 | 3 |

+| 数据 | data_replication_factor | 1 | 2 |

\ No newline at end of file

diff --git a/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md b/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md

new file mode 100644

index 000000000..3584aabb1

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md

@@ -0,0 +1,184 @@

+

+

+# 数据类型

+

+## 基本数据类型

+

+IoTDB 支持以下十种数据类型:

+

+* BOOLEAN(布尔值)

+* INT32(整型)

+* INT64(长整型)

+* FLOAT(单精度浮点数)

+* DOUBLE(双精度浮点数)

+* TEXT(长字符串)

+* STRING(字符串)

+* BLOB(大二进制对象)

+* TIMESTAMP(时间戳)

+* DATE(日期)

+

+其中,STRING 和 TEXT 类型的区别在于,STRING 类型具有更多的统计信息,能够用于优化值过滤查询。TEXT 类型适合用于存储长字符串。

+

+### 浮点数精度配置

+

+对于 **FLOAT** 与 **DOUBLE** 类型的序列,如果编码方式采用 `RLE`或 `TS_2DIFF`,可以在创建序列时通过 `MAX_POINT_NUMBER` 属性指定浮点数的小数点后位数。

+

+例如,

+```sql

+CREATE TIMESERIES root.vehicle.d0.s0 WITH DATATYPE=FLOAT, ENCODING=RLE, 'MAX_POINT_NUMBER'='2';

+```

+

+若不指定,系统会按照配置文件 `iotdb-system.properties` 中的 [float_precision](../Reference/Common-Config-Manual.md) 项配置(默认为 2 位)。

+

+### 数据类型兼容性

+

+当写入数据的类型与序列注册的数据类型不一致时,

+- 如果序列数据类型不兼容写入数据类型,系统会给出错误提示。

+- 如果序列数据类型兼容写入数据类型,系统会进行数据类型的自动转换,将写入的数据类型更正为注册序列的类型。

+

+各数据类型的兼容情况如下表所示:

+

+| 序列数据类型 | 支持的写入数据类型 |

+|--------------|--------------------------|

+| BOOLEAN | BOOLEAN |

+| INT32 | INT32 |

+| INT64 | INT32 INT64 |

+| FLOAT | INT32 FLOAT |

+| DOUBLE | INT32 INT64 FLOAT DOUBLE |

+| TEXT | TEXT |

+

+## 时间戳类型

+

+时间戳是一个数据到来的时间点,其中包括绝对时间戳和相对时间戳。

+

+### 绝对时间戳

+

+IOTDB 中绝对时间戳分为二种,一种为 LONG 类型,一种为 DATETIME 类型(包含 DATETIME-INPUT, DATETIME-DISPLAY 两个小类)。

+

+在用户在输入时间戳时,可以使用 LONG 类型的时间戳或 DATETIME-INPUT 类型的时间戳,其中 DATETIME-INPUT 类型的时间戳支持格式如表所示:

+

+

+

+其中包括了 IoTDB 集群使用中用户常接触到的几个概念,包括:

+- **节点**(ConfigNode、DataNode、AINode);

+- **槽**(SchemaSlot、DataSlot);

+- **Region**(SchemaRegion、DataRegion);

+- ***副本组***。

+

+下文将重点对以上概念进行介绍。

+

+## 节点

+IoTDB 集群包括三种节点(进程),**ConfigNode**(管理节点),**DataNode**(数据节点)和 **AINode**(分析节点),如下所示:

+- **ConfigNode**:存储集群的配置信息、数据库的元数据、时间序列元数据和数据的路由信息,监控集群节点并实施负载均衡,所有 ConfigNode 之间互为全量备份,如上图中的 ConfigNode-1,ConfigNode-2 和 ConfigNode-3 所示。ConfigNode 不直接接收客户端读写请求,它会通过一系列[负载均衡算法](../Technical-Insider/Cluster-data-partitioning.md)对集群中元数据和数据的分布提供指导。

+- **DataNode**:负责时间序列元数据和数据的读写,每个 DataNode 都能接收客户端读写请求并提供相应服务,如上图中的 DataNode-1,DataNode-2 和 DataNode-3 所示。接收客户端读写请求时,若 DataNode 缓存有对应的路由信息,它能直接在本地执行或是转发这些请求;否则它会向 ConfigNode 询问并缓存路由信息,以加速后续请求的服务效率。

+- **AINode**:负责与 ConfigNode 和 DataNode 交互来扩展 IoTDB 集群对时间序列进行智能分析的能力,支持从外部引入已有机器学习模型进行注册,并使用注册的模型在指定时序数据上通过简单 SQL 语句完成时序分析任务的过程,将模型的创建、管理及推理融合在数据库引擎中。目前已提供常见时序分析场景(例如预测与异常检测)的机器学习算法或自研模型。

+

+## 槽

+IoTDB 内部将元数据和数据划分成多个更小的、更易于管理的单元,每个单元称为一个**槽**。槽是一个逻辑概念,在 IoTDB 集群中,**元数据槽**和**数据槽**定义如下:

+- **元数据槽**(SchemaSlot):一部分元数据集合,元数据槽总数固定,默认数量为 1000,IoTDB 使用哈希算法将所有设备均匀地分配到这些元数据槽中。

+- **数据槽**(DataSlot):一部分数据集合,在元数据槽的基础上,将对应设备的数据按时间范围划分为数据槽,默认的时间范围为 7 天。

+

+## Region

+在 IoTDB 中,元数据和数据被复制到各个 DataNode 以获得集群高可用性。然而以槽为粒度进行复制会增加集群管理成本、降低写入吞吐。因此 IoTDB 引入 **Region** 这一概念,将元数据槽和数据槽分别分配给 SchemaRegion 和 DataRegion 后,以 Region 为单位进行复制。**SchemRegion** 和 **DataRegion** 的详细定义如下:

+- **SchemaRegion**:元数据存储和复制的基本单元,集群每个数据库的所有元数据槽会被均匀分配给该数据库的所有 SchemaRegion。拥有相同 RegionID 的 SchemaRegion 互为副本,如上图中 SchemaRegion-1 拥有三个副本,分别放置于 DataNode-1,DataNode-2 和 DataNode-3。

+- **DataRegion**:数据存储和复制的基本单元,集群每个数据库的所有数据槽会被均匀分配给该数据库的所有 DataRegion。拥有相同 RegionID 的 DataRegion 互为副本,如上图中 DataRegion-2 拥有两个副本,分别放置于 DataNode-1 和 DataNode-2。

+

+## 副本组

+Region 的副本对集群的容灾能力至关重要。对于每个 Region 的所有副本,它们的角色分为 **leader** 和 **follower**,共同提供读写服务。不同架构下的副本组配置推荐如下:

+| 类别 | 配置项 | 单机推荐配置 | 分布式推荐配置 |

+| :-: | :-: | :-: | :-: |

+| 元数据 | schema_replication_factor | 1 | 3 |

+| 数据 | data_replication_factor | 1 | 2 |

\ No newline at end of file

diff --git a/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md b/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md

new file mode 100644

index 000000000..3584aabb1

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/Background-knowledge/Data-Type.md

@@ -0,0 +1,184 @@

+

+

+# 数据类型

+

+## 基本数据类型

+

+IoTDB 支持以下十种数据类型:

+

+* BOOLEAN(布尔值)

+* INT32(整型)

+* INT64(长整型)

+* FLOAT(单精度浮点数)

+* DOUBLE(双精度浮点数)

+* TEXT(长字符串)

+* STRING(字符串)

+* BLOB(大二进制对象)

+* TIMESTAMP(时间戳)

+* DATE(日期)

+

+其中,STRING 和 TEXT 类型的区别在于,STRING 类型具有更多的统计信息,能够用于优化值过滤查询。TEXT 类型适合用于存储长字符串。

+

+### 浮点数精度配置

+

+对于 **FLOAT** 与 **DOUBLE** 类型的序列,如果编码方式采用 `RLE`或 `TS_2DIFF`,可以在创建序列时通过 `MAX_POINT_NUMBER` 属性指定浮点数的小数点后位数。

+

+例如,

+```sql

+CREATE TIMESERIES root.vehicle.d0.s0 WITH DATATYPE=FLOAT, ENCODING=RLE, 'MAX_POINT_NUMBER'='2';

+```

+

+若不指定,系统会按照配置文件 `iotdb-system.properties` 中的 [float_precision](../Reference/Common-Config-Manual.md) 项配置(默认为 2 位)。

+

+### 数据类型兼容性

+

+当写入数据的类型与序列注册的数据类型不一致时,

+- 如果序列数据类型不兼容写入数据类型,系统会给出错误提示。

+- 如果序列数据类型兼容写入数据类型,系统会进行数据类型的自动转换,将写入的数据类型更正为注册序列的类型。

+

+各数据类型的兼容情况如下表所示:

+

+| 序列数据类型 | 支持的写入数据类型 |

+|--------------|--------------------------|

+| BOOLEAN | BOOLEAN |

+| INT32 | INT32 |

+| INT64 | INT32 INT64 |

+| FLOAT | INT32 FLOAT |

+| DOUBLE | INT32 INT64 FLOAT DOUBLE |

+| TEXT | TEXT |

+

+## 时间戳类型

+

+时间戳是一个数据到来的时间点,其中包括绝对时间戳和相对时间戳。

+

+### 绝对时间戳

+

+IOTDB 中绝对时间戳分为二种,一种为 LONG 类型,一种为 DATETIME 类型(包含 DATETIME-INPUT, DATETIME-DISPLAY 两个小类)。

+

+在用户在输入时间戳时,可以使用 LONG 类型的时间戳或 DATETIME-INPUT 类型的时间戳,其中 DATETIME-INPUT 类型的时间戳支持格式如表所示:

+

+

+

+**DATETIME-INPUT 类型支持格式**

+

+

+| format |

+| :--------------------------- |

+| yyyy-MM-dd HH:mm:ss |

+| yyyy/MM/dd HH:mm:ss |

+| yyyy.MM.dd HH:mm:ss |

+| yyyy-MM-dd HH:mm:ssZZ |

+| yyyy/MM/dd HH:mm:ssZZ |

+| yyyy.MM.dd HH:mm:ssZZ |

+| yyyy/MM/dd HH:mm:ss.SSS |

+| yyyy-MM-dd HH:mm:ss.SSS |

+| yyyy.MM.dd HH:mm:ss.SSS |

+| yyyy-MM-dd HH:mm:ss.SSSZZ |

+| yyyy/MM/dd HH:mm:ss.SSSZZ |

+| yyyy.MM.dd HH:mm:ss.SSSZZ |

+| ISO8601 standard time format |

+

+

+

+

+

+IoTDB 在显示时间戳时可以支持 LONG 类型以及 DATETIME-DISPLAY 类型,其中 DATETIME-DISPLAY 类型可以支持用户自定义时间格式。自定义时间格式的语法如表所示:

+

+

+

+**DATETIME-DISPLAY 自定义时间格式的语法**

+

+

+| Symbol | Meaning | Presentation | Examples |

+| :----: | :-------------------------: | :----------: | :--------------------------------: |

+| G | era | era | era |

+| C | century of era (>=0) | number | 20 |

+| Y | year of era (>=0) | year | 1996 |

+| | | | |

+| x | weekyear | year | 1996 |

+| w | week of weekyear | number | 27 |

+| e | day of week | number | 2 |

+| E | day of week | text | Tuesday; Tue |

+| | | | |

+| y | year | year | 1996 |

+| D | day of year | number | 189 |

+| M | month of year | month | July; Jul; 07 |

+| d | day of month | number | 10 |

+| | | | |

+| a | halfday of day | text | PM |

+| K | hour of halfday (0~11) | number | 0 |

+| h | clockhour of halfday (1~12) | number | 12 |

+| | | | |

+| H | hour of day (0~23) | number | 0 |

+| k | clockhour of day (1~24) | number | 24 |

+| m | minute of hour | number | 30 |

+| s | second of minute | number | 55 |

+| S | fraction of second | millis | 978 |

+| | | | |

+| z | time zone | text | Pacific Standard Time; PST |

+| Z | time zone offset/id | zone | -0800; -08:00; America/Los_Angeles |

+| | | | |

+| ' | escape for text | delimiter | |

+| '' | single quote | literal | ' |

+

+

+

+### 相对时间戳

+

+ 相对时间是指与服务器时间```now()```和```DATETIME```类型时间相差一定时间间隔的时间。

+ 形式化定义为:

+

+ ```

+ Duration = (Digit+ ('Y'|'MO'|'W'|'D'|'H'|'M'|'S'|'MS'|'US'|'NS'))+

+ RelativeTime = (now() | DATETIME) ((+|-) Duration)+

+ ```

+

+

+

+ **The syntax of the duration unit**

+

+

+ | Symbol | Meaning | Presentation | Examples |

+ | :----: | :---------: | :----------------------: | :------: |

+ | y | year | 1y=365 days | 1y |

+ | mo | month | 1mo=30 days | 1mo |

+ | w | week | 1w=7 days | 1w |

+ | d | day | 1d=1 day | 1d |

+ | | | | |

+ | h | hour | 1h=3600 seconds | 1h |

+ | m | minute | 1m=60 seconds | 1m |

+ | s | second | 1s=1 second | 1s |

+ | | | | |

+ | ms | millisecond | 1ms=1000_000 nanoseconds | 1ms |

+ | us | microsecond | 1us=1000 nanoseconds | 1us |

+ | ns | nanosecond | 1ns=1 nanosecond | 1ns |

+

+

+

+ 例子:

+

+ ```

+ now() - 1d2h //比服务器时间早 1 天 2 小时的时间

+ now() - 1w //比服务器时间早 1 周的时间

+ ```

+

+ > 注意:'+'和'-'的左右两边必须有空格

\ No newline at end of file

diff --git a/src/zh/UserGuide/Master/Table/Basic-Concept/Data-Model-and-Terminology.md b/src/zh/UserGuide/Master/Table/Basic-Concept/Data-Model-and-Terminology.md

new file mode 100644

index 000000000..166401607

--- /dev/null

+++ b/src/zh/UserGuide/Master/Table/Basic-Concept/Data-Model-and-Terminology.md

@@ -0,0 +1,161 @@

+

+

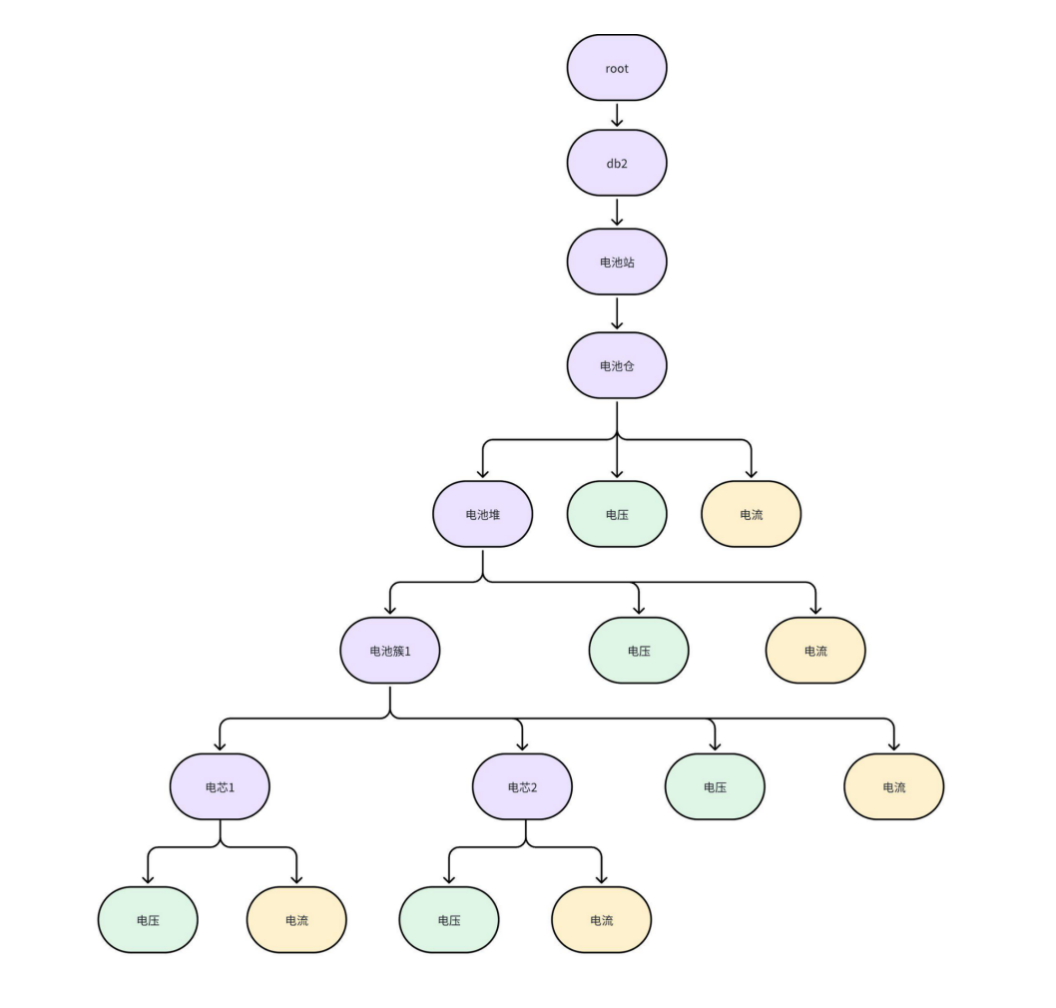

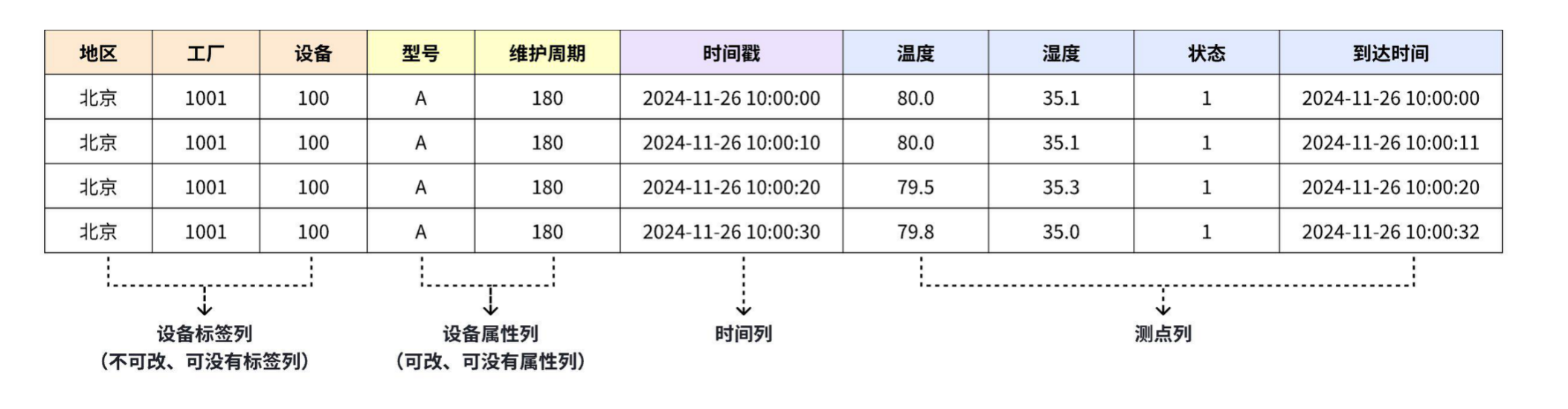

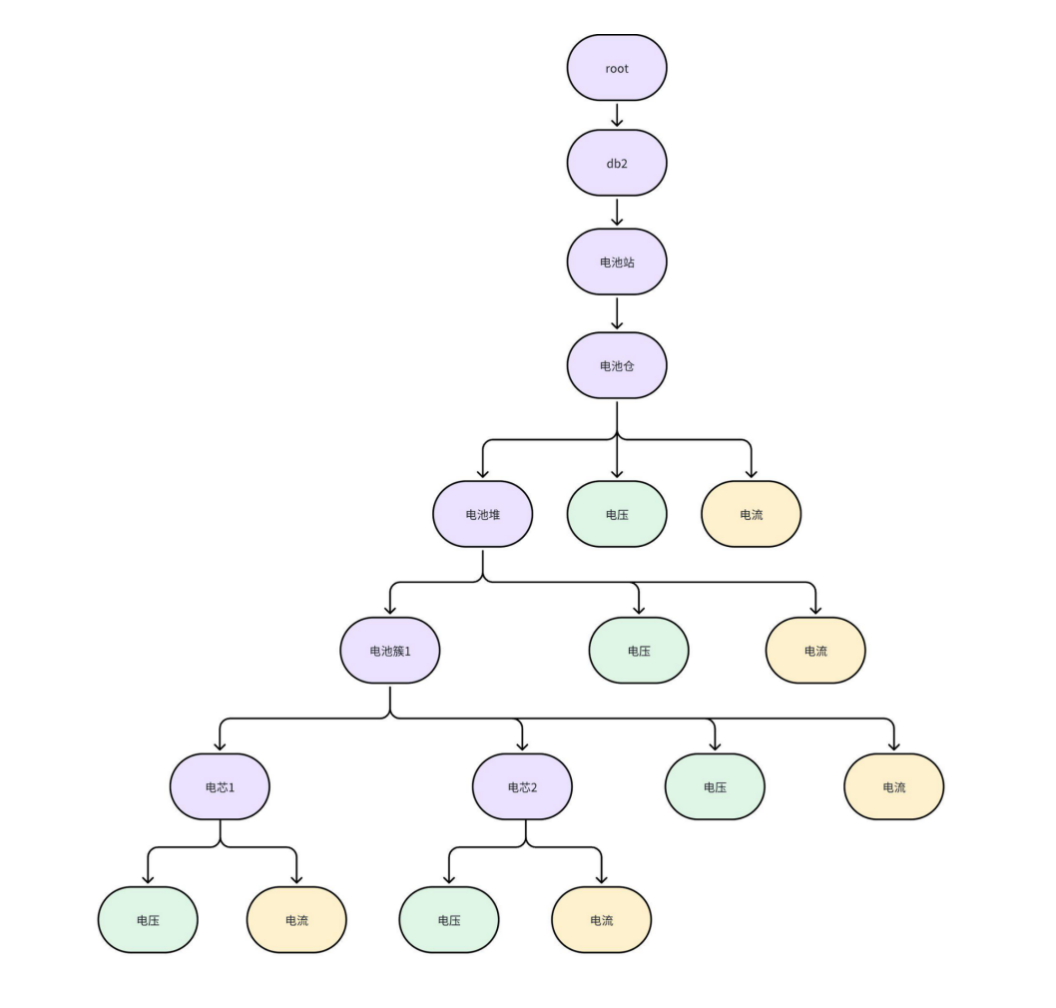

+# 建模方案设计

+

+本章节主要介绍如何将时序数据应用场景转化为IoTDB时序建模。

+

+## 1 时序数据模型

+

+在构建IoTDB建模方案前,需要先了解时序数据和时序数据模型,详细内容见此页面:[时序数据模型](../Basic-Concept/Navigating_Time_Series_Data.md)

+

+## 2 IoTDB 的两种时序模型

+

+> IoTDB 提供了两种数据建模方式——树模型和表模型,以满足用户多样化的应用需求。

+

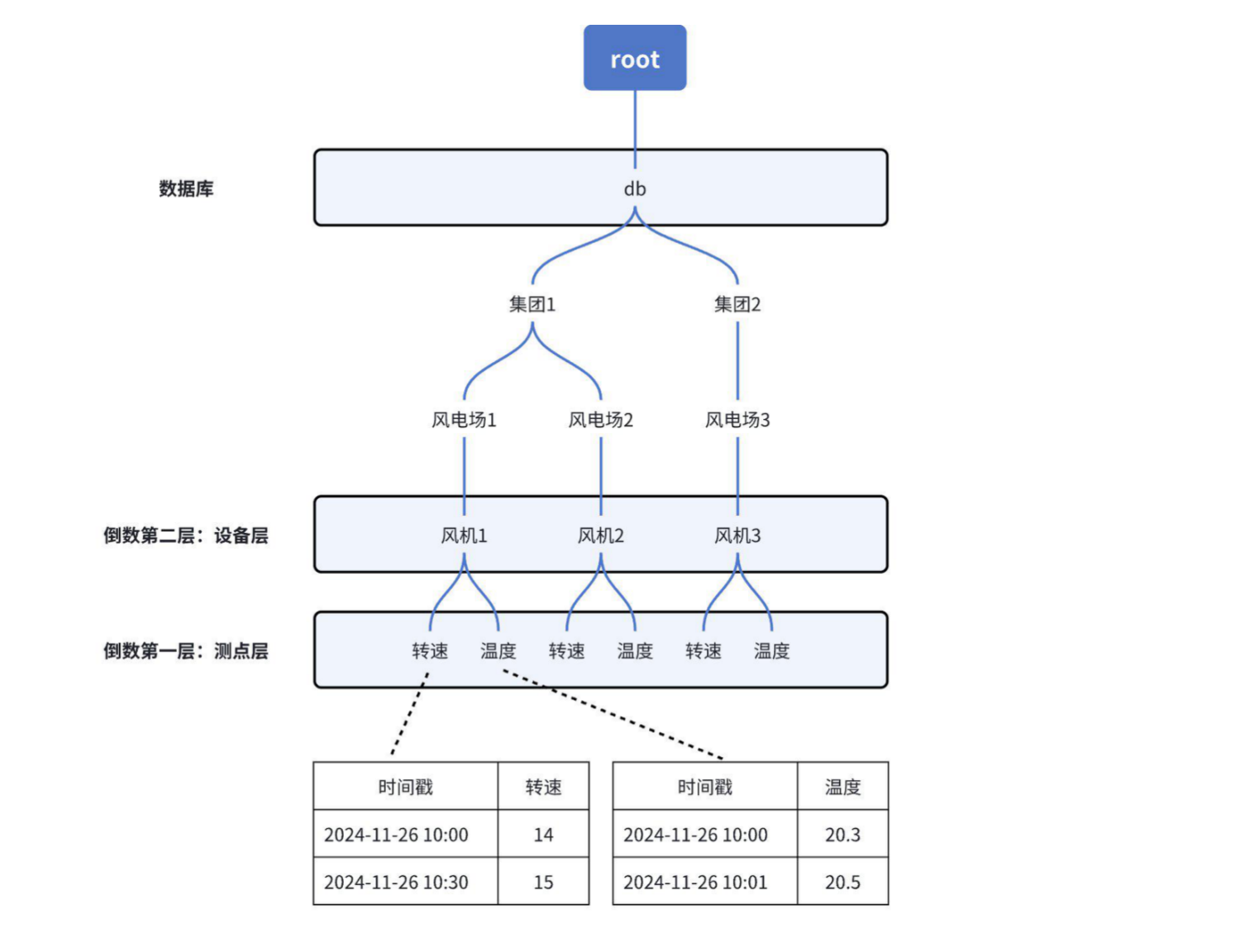

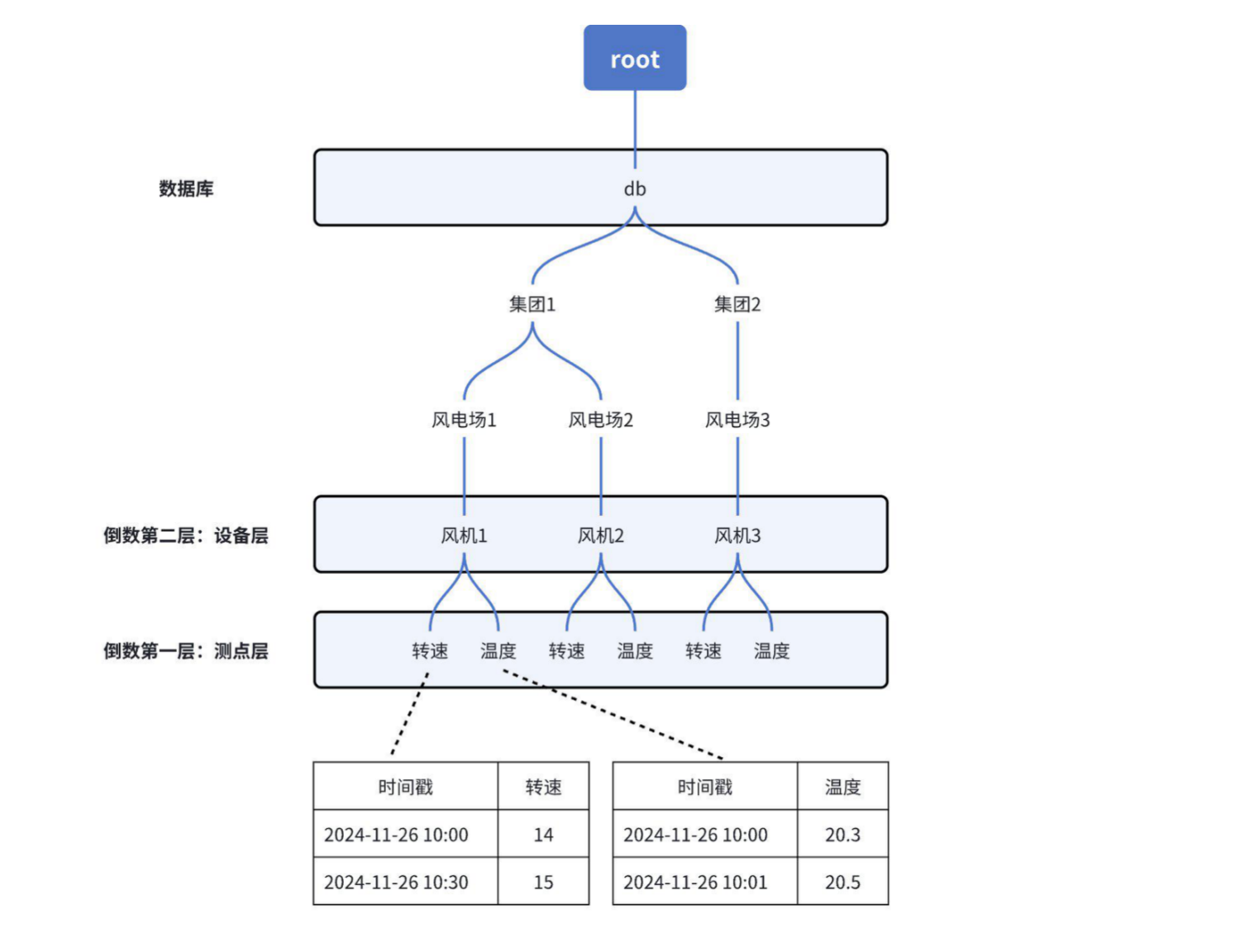

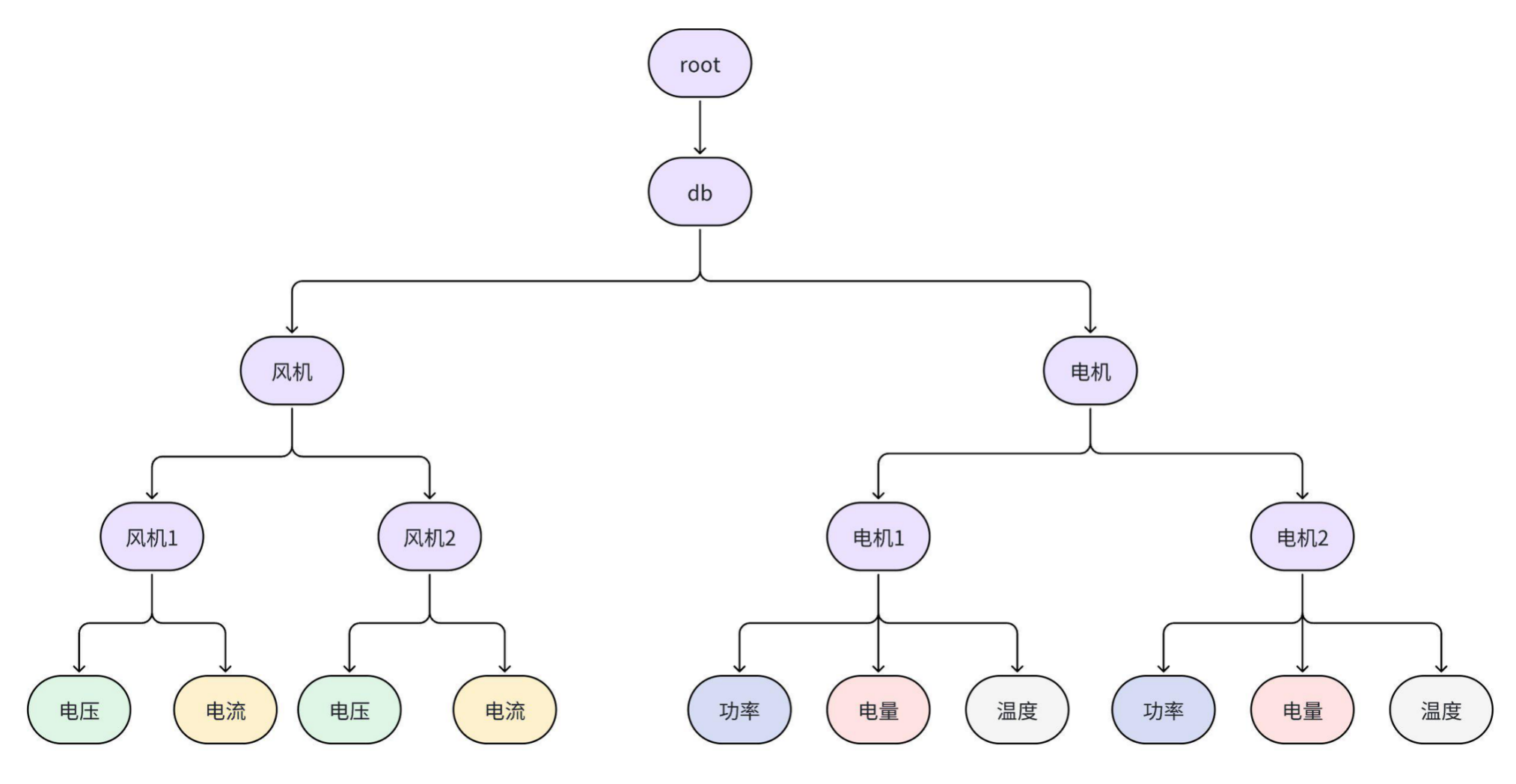

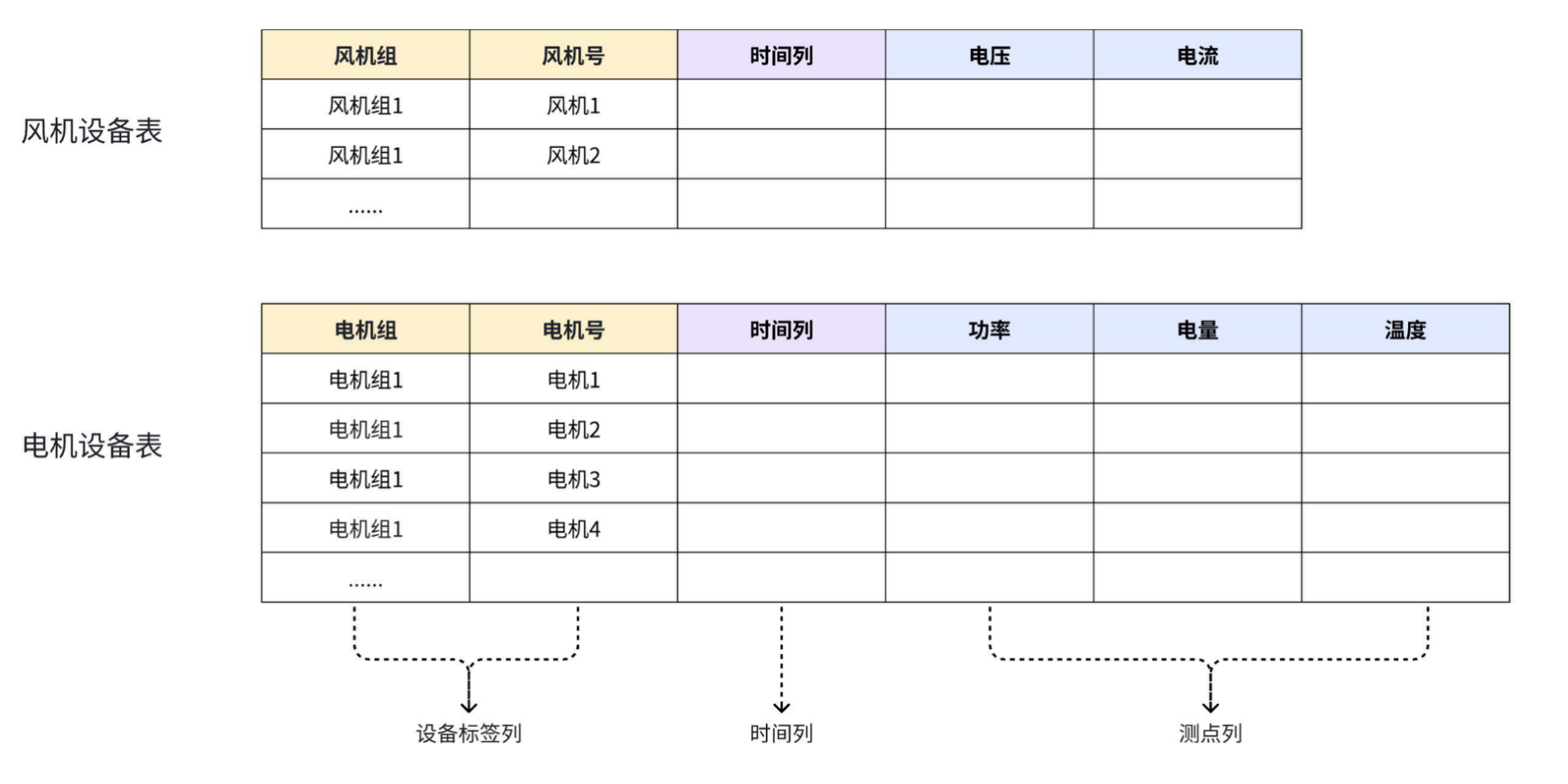

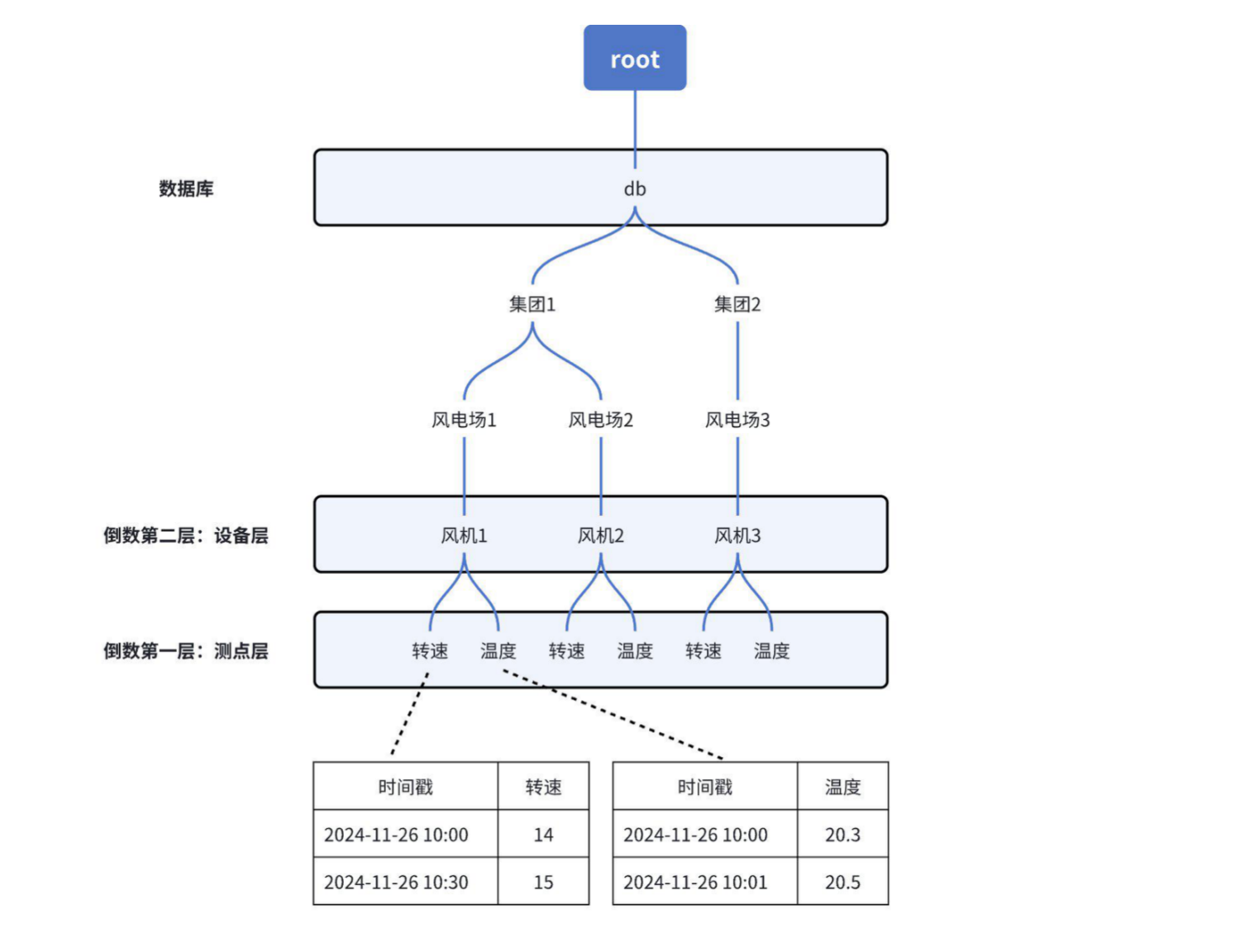

+### 2.1 树模型(测点管理模型):一条路径管理一个测点

+

+以测点为单元进行管理,每个测点对应一条时间序列,测点名按逗号分割可看作一个树形目录结构,与物理世界一一对应,简单直观。

+

+示例:下图是一个风电场的建模管理,通过多个层级【集团】-【风电场】-【风机】-【物理量】可以唯一确定一个实体测点。

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

-## 注意事项

+## 1 注意事项

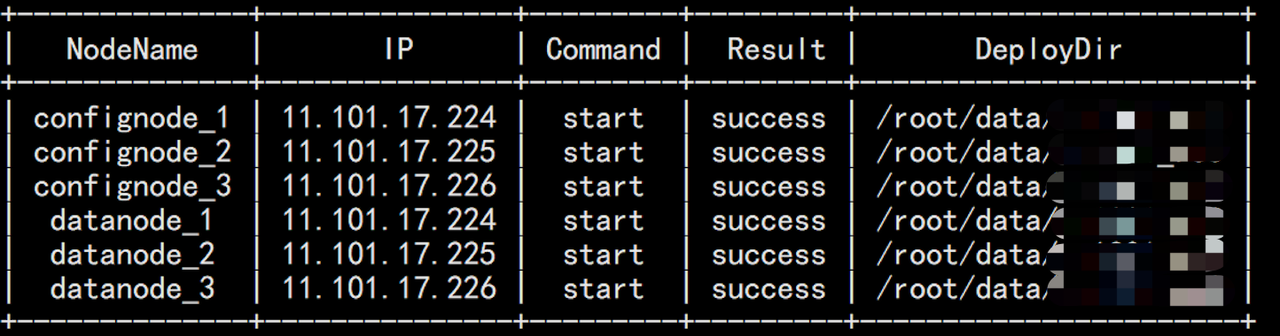

1. 安装前请确认系统已参照[系统配置](../Deployment-and-Maintenance/Environment-Requirements.md)准备完成。

@@ -52,12 +52,12 @@

6. 推荐部署监控面板,可以对重要运行指标进行监控,随时掌握数据库运行状态,监控面板可以联系商务获取,部署监控面板步骤可以参考:[监控面板部署](./Monitoring-panel-deployment.md)

-## 准备步骤

+## 2 准备步骤

1. 准备IoTDB数据库安装包 :timechodb-{version}-bin.zip(安装包获取见:[链接](./IoTDB-Package_timecho.md))

2. 按环境要求配置好操作系统环境(系统环境配置见:[链接](./Environment-Requirements.md))

-## 安装步骤

+## 3 安装步骤

假设现在有3台linux服务器,IP地址和服务角色分配如下:

@@ -67,7 +67,7 @@

| 11.101.17.225 | iotdb-2 | ConfigNode、DataNode |

| 11.101.17.226 | iotdb-3 | ConfigNode、DataNode |

-### 设置主机名

+### 3.1 设置主机名

在3台机器上分别配置主机名,设置主机名需要在目标服务器上配置/etc/hosts,使用如下命令:

@@ -77,7 +77,7 @@ echo "11.101.17.225 iotdb-2" >> /etc/hosts

echo "11.101.17.226 iotdb-3" >> /etc/hosts

```

-### 参数配置

+### 3.2 参数配置

解压安装包并进入安装目录

@@ -86,7 +86,7 @@ unzip timechodb-{version}-bin.zip

cd timechodb-{version}-bin

```

-#### 环境脚本配置

+#### 3.2.1 环境脚本配置

- ./conf/confignode-env.sh配置

@@ -100,7 +100,7 @@ cd timechodb-{version}-bin

| :---------- | :----------------------------------- | :--------- | :----------------------------------------------- | :----------- |

| MEMORY_SIZE | IoTDB DataNode节点可以使用的内存总量 | 空 | 可按需填写,填写后系统会根据填写的数值来分配内存 | 重启服务生效 |

-#### 通用配置(./conf/iotdb-system.properties)

+#### 3.2.2 通用配置(./conf/iotdb-system.properties)

- 集群配置

@@ -110,7 +110,7 @@ cd timechodb-{version}-bin

| schema_replication_factor | 元数据副本数,DataNode数量不应少于此数目 | 3 | 3 | 3 |

| data_replication_factor | 数据副本数,DataNode数量不应少于此数目 | 2 | 2 | 2 |

-#### ConfigNode 配置

+#### 3.2.3 ConfigNode 配置

| 配置项 | 说明 | 默认 | 推荐值 | 11.101.17.224 | 11.101.17.225 | 11.101.17.226 | 备注 |

| ------------------- | ------------------------------------------------------------ | --------------- | ------------------------------------------------------- | ------------- | ------------- | ------------- | ------------------ |

@@ -119,7 +119,7 @@ cd timechodb-{version}-bin

| cn_consensus_port | ConfigNode副本组共识协议通信使用的端口 | 10720 | 10720 | 10720 | 10720 | 10720 | 首次启动后不能修改 |

| cn_seed_config_node | 节点注册加入集群时连接的ConfigNode 的地址,cn_internal_address:cn_internal_port | 127.0.0.1:10710 | 第一个CongfigNode的cn_internal_address:cn_internal_port | iotdb-1:10710 | iotdb-1:10710 | iotdb-1:10710 | 首次启动后不能修改 |

-#### DataNode 配置

+#### 3.2.4 DataNode 配置

| 配置项 | 说明 | 默认 | 推荐值 | 11.101.17.224 | 11.101.17.225 | 11.101.17.226 | 备注 |

| ------------------------------- | ------------------------------------------------------------ | --------------- | ------------------------------------------------------- | ------------- | ------------- | ------------- | ------------------ |

@@ -134,7 +134,7 @@ cd timechodb-{version}-bin

> ❗️注意:VSCode Remote等编辑器无自动保存配置功能,请确保修改的文件被持久化保存,否则配置项无法生效

-### 启动ConfigNode节点

+### 3.3 启动ConfigNode节点

先启动第一个iotdb-1的confignode, 保证种子confignode节点先启动,然后依次启动第2和第3个confignode节点

@@ -145,7 +145,7 @@ cd sbin

如果启动失败,请参考下[常见问题](#常见问题)

-### 启动DataNode 节点

+### 3.4 启动DataNode 节点

分别进入iotdb的sbin目录下,依次启动3个datanode节点:

@@ -154,7 +154,7 @@ cd sbin

./start-datanode.sh -d #-d参数将在后台进行启动

```

-### 激活数据库

+### 3.5 激活数据库

#### 方式一:激活文件拷贝激活

@@ -214,15 +214,15 @@ cd sbin

IoTDB> activate '01-D4EYQGPZ-EAUJJODW-NUKRDR6F-TUQS3B75-EDZFLK3A-6BOKJFFZ-ALDHOMN7-NB2E4BHI-7ZKGFVK6-GCIFXA4T-UG3XJTTD-SHJV6F2P-Q27B4OMJ-R47ZDIM3-UUASUXG2-OQXGVZCO-MMYKICZU-TWFQYYAO-ZOAGOKJA-NYHQTA5U-EWAR4EP5-MRC6R2CI-PKUTKRCT-7UDGRH3F-7BYV4P5D-6KKIA===,01-D4EYQGPZ-EAUJJODW-NUKRDR6F-TUQS3B75-EDZFLK3A-6BOKJFFZ-ALDHOMN7-NB2E4BHI-7ZKGFVK6-GCIFXA4T-UG3XJTTD-SHJV6F2P-Q27B4OMJ-R47ZDIM3-UUASUXG2-OQXGVZCO-MMYKICZU-TWFQYYAO-ZOAGOKJA-NYHQTA5U-EWAR4EP5-MRC6R2CI-PKUTKRCT-7UDGRH3F-7BYV4P5D-6KKIA===,01-D4EYQGPZ-EAUJJODW-NUKRDR6F-TUQS3B75-EDZFLK3A-6BOKJFFZ-ALDHOMN7-NB2E4BHI-7ZKGFVK6-GCIFXA4T-UG3XJTTD-SHJV6F2P-Q27B4OMJ-R47ZDIM3-UUASUXG2-OQXGVZCO-MMYKICZU-TWFQYYAO-ZOAGOKJA-NYHQTA5U-EWAR4EP5-MRC6R2CI-PKUTKRCT-7UDGRH3F-7BYV4P5D-6KKIA==='

```

-### 验证激活

+### 3.6 验证激活

当看到“Result”字段状态显示为success表示激活成功

-## 节点维护步骤

+## 4 节点维护步骤

-### ConfigNode节点维护

+### 4.1 ConfigNode节点维护

ConfigNode节点维护分为ConfigNode添加和移除两种操作,有两个常见使用场景:

@@ -231,7 +231,7 @@ ConfigNode节点维护分为ConfigNode添加和移除两种操作,有两个常

> ❗️注意,在完成ConfigNode节点维护后,需要保证集群中有1或者3个正常运行的ConfigNode。2个ConfigNode不具备高可用性,超过3个ConfigNode会导致性能损失。

-#### 添加ConfigNode节点

+#### 4.1.1 添加ConfigNode节点

脚本命令:

@@ -245,7 +245,7 @@ sbin/start-confignode.sh

sbin/start-confignode.bat

```

-#### 移除ConfigNode节点

+#### 4.1.2 移除ConfigNode节点

首先通过CLI连接集群,通过`show confignodes`确认想要移除ConfigNode的内部地址与端口号:

@@ -276,7 +276,7 @@ sbin/remove-confignode.bat [confignode_id]

./sbin/remove-confignode.bat [cn_internal_address:cn_internal_port]

```

-### DataNode节点维护

+### 4.2 DataNode节点维护

DataNode节点维护有两个常见场景:

@@ -285,7 +285,7 @@ DataNode节点维护有两个常见场景:

> ❗️注意,为了使集群能正常工作,在DataNode节点维护过程中以及维护完成后,正常运行的DataNode总数不得少于数据副本数(通常为2),也不得少于元数据副本数(通常为3)。

-#### 添加DataNode节点

+#### 4.2.1 添加DataNode节点

脚本命令:

@@ -301,7 +301,7 @@ sbin/start-datanode.bat

说明:在添加DataNode后,随着新的写入到来(以及旧数据过期,如果设置了TTL),集群负载会逐渐向新的DataNode均衡,最终在所有节点上达到存算资源的均衡。

-#### 移除DataNode节点

+#### 4.2.2 移除DataNode节点

首先通过CLI连接集群,通过`show datanodes`确认想要移除的DataNode的RPC地址与端口号:

@@ -328,7 +328,7 @@ sbin/remove-datanode.sh [dn_rpc_address:dn_rpc_port]

sbin/remove-datanode.bat [dn_rpc_address:dn_rpc_port]

```

-## 常见问题

+## 5 常见问题

1. 部署过程中多次提示激活失败

- 使用 `ls -al` 命令:使用 `ls -al` 命令检查安装包根目录的所有者信息是否为当前用户。

@@ -360,15 +360,15 @@ sbin/remove-datanode.bat [dn_rpc_address:dn_rpc_port]

```shell

cd /data/iotdb rm -rf data logs

```

-## 附录

+## 6 附录

-### Confignode节点参数介绍

+### 6.1 Confignode节点参数介绍

| 参数 | 描述 | 是否为必填项 |

| :--- | :------------------------------- | :----------- |

| -d | 以守护进程模式启动,即在后台运行 | 否 |

-### Datanode节点参数介绍

+### 6.2 Datanode节点参数介绍

| 缩写 | 描述 | 是否为必填项 |

| :--- | :--------------------------------------------- | :----------- |

diff --git a/src/zh/UserGuide/Master/Table/Deployment-and-Maintenance/Database-Resources.md b/src/zh/UserGuide/Master/Table/Deployment-and-Maintenance/Database-Resources.md

index 5b85630b4..fe6133025 100644

--- a/src/zh/UserGuide/Master/Table/Deployment-and-Maintenance/Database-Resources.md

+++ b/src/zh/UserGuide/Master/Table/Deployment-and-Maintenance/Database-Resources.md

@@ -19,7 +19,8 @@

-->

# 资源规划

-## CPU

+

+## 1 CPU

-## 内存

+## 2 内存

-## 存储(磁盘)

-### 存储空间

+## 3 存储(磁盘)

+### 3.1 存储空间

计算公式:测点数量 * 采样频率(Hz)* 每个数据点大小(Byte,不同数据类型不一样,见下表)

-## 注意事项

+## 1 注意事项

1. 安装前请确认系统已参照[系统配置](../Deployment-and-Maintenance/Environment-Requirements.md)准备完成。

@@ -52,12 +52,12 @@

6. 推荐部署监控面板,可以对重要运行指标进行监控,随时掌握数据库运行状态,监控面板可以联系商务获取,部署监控面板步骤可以参考:[监控面板部署](./Monitoring-panel-deployment.md)

-## 准备步骤

+## 2 准备步骤

1. 准备IoTDB数据库安装包 :timechodb-{version}-bin.zip(安装包获取见:[链接](./IoTDB-Package_timecho.md))

2. 按环境要求配置好操作系统环境(系统环境配置见:[链接](./Environment-Requirements.md))

-## 安装步骤

+## 3 安装步骤

假设现在有3台linux服务器,IP地址和服务角色分配如下:

@@ -67,7 +67,7 @@

| 11.101.17.225 | iotdb-2 | ConfigNode、DataNode |

| 11.101.17.226 | iotdb-3 | ConfigNode、DataNode |

-### 设置主机名

+### 3.1 设置主机名

在3台机器上分别配置主机名,设置主机名需要在目标服务器上配置/etc/hosts,使用如下命令:

@@ -77,7 +77,7 @@ echo "11.101.17.225 iotdb-2" >> /etc/hosts

echo "11.101.17.226 iotdb-3" >> /etc/hosts

```

-### 参数配置

+### 3.2 参数配置

解压安装包并进入安装目录

@@ -86,7 +86,7 @@ unzip timechodb-{version}-bin.zip

cd timechodb-{version}-bin

```

-#### 环境脚本配置

+#### 3.2.1 环境脚本配置

- ./conf/confignode-env.sh配置

@@ -100,7 +100,7 @@ cd timechodb-{version}-bin

| :---------- | :----------------------------------- | :--------- | :----------------------------------------------- | :----------- |

| MEMORY_SIZE | IoTDB DataNode节点可以使用的内存总量 | 空 | 可按需填写,填写后系统会根据填写的数值来分配内存 | 重启服务生效 |

-#### 通用配置(./conf/iotdb-system.properties)

+#### 3.2.2 通用配置(./conf/iotdb-system.properties)

- 集群配置

@@ -110,7 +110,7 @@ cd timechodb-{version}-bin

| schema_replication_factor | 元数据副本数,DataNode数量不应少于此数目 | 3 | 3 | 3 |

| data_replication_factor | 数据副本数,DataNode数量不应少于此数目 | 2 | 2 | 2 |

-#### ConfigNode 配置

+#### 3.2.3 ConfigNode 配置

| 配置项 | 说明 | 默认 | 推荐值 | 11.101.17.224 | 11.101.17.225 | 11.101.17.226 | 备注 |